Интересная тема для написания этого статистического поста возникла сама собой, когда было решено проверить черный список сайтов на одном из аккаунтов SAPE.

Мной неоднократно писались статьи и затрагивается часто эта тема - как правильно фильтровать ссылочную массу. Естественно в блоге есть материалы на основе которых формировался этот черный список:

- Фильтрация ссылок и ошибки сателлитщиков.

- Чистка ссылочной массы и фильтрация сеток.

- Естественные и неестественные ссылки – вебмастер сам подскажет.

- Покупка ссылок: классификация параметров для отсева.

- Про ссылочную массу и ее рациональное использование.

Все статьи написаны на основе опыта, который был получен в результате тестов и ошибок. Чтож... Я думаю настала пора "прочекать" аккаунт с черным списком в 68701 сайт. Это мой личный аккаунт, не клиентские - где добавляются и другие параметры отсева. Свои принципы фильтрации я описывал - чуть выше. Теперь давайте посмотрим на результаты.

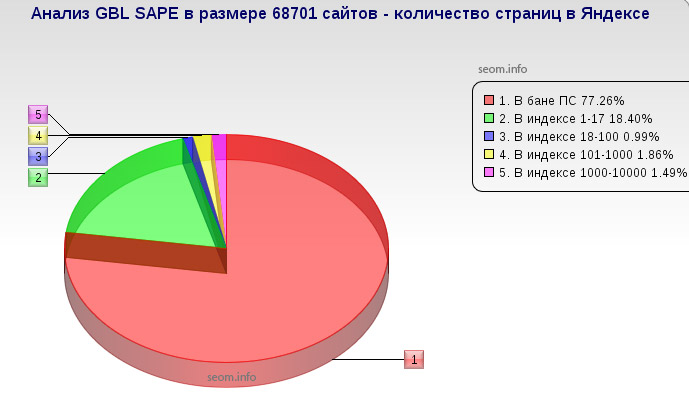

Первым делом - мне было интересно узнать, какой % базы находится в бане и под АГС, т.е. насколько качественно подобраны предварительные параметры отсева, которые дают признаки для занесения в черный список.

Для этого мы проверили 68701 сайт в Яндексе и узнали сколько на каждом из них проиндексированных страниц.

- 77.26% - находится в бане поисковой системы Яндекс.

- 18.40% - имеют в индексе до 17 страниц, а значит с большой долей вероятности их настиг фильтр АГС.

- 0.99% - имеют в индексе от 18 до 100 страниц, что тоже не есть хорошо.

- 1.86% - имеют в индексе от 101 до 1000 страниц.

- 1.49% - имеют в индексе Яндекса 1000-10000 страниц.

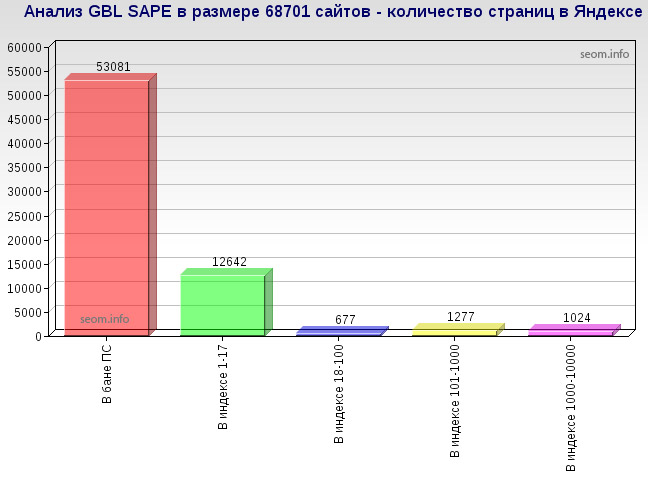

Что в количественном выражении выглядит так.

Более 53 тысяч сайтов в принципе не имеют ни одной страницы в индексе, более 12 тысяч находятся под фильтрами, почти 700 не подходят по кол-ву страниц, остальное - погрешность?

Фильтры дали сбой и более 2 тысяч сайтов попали в черный список просто так, имея при этом тысячи страниц в индексе? - Финишь! Все пропало!

Все бы хорошо, но не совсем так ![]() Важно знать по каким критериям они туда попали, тогда можно будет делать более реальные выводы.

Важно знать по каким критериям они туда попали, тогда можно будет делать более реальные выводы.

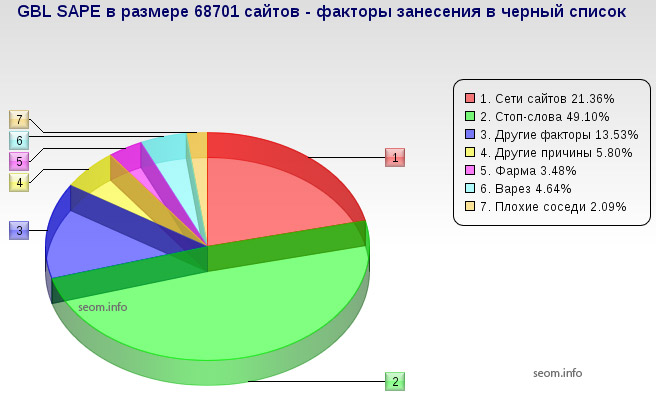

А вот и факторы, которые повлияли на внесение сайтов в черный список (ГБЛ):

- 21.36% - сетки сайтов, которые точно рано или поздно должны были вылететь из индекса.

- 49.10% - имеют в наличии нежелательные элементы, стоп-слова, которые не позволяют покупать на них ссылки.

- 13.53% - другие факторы, не позволившие купить ссылки.

Здесь стоит упомянуть, что другие причины, а также пункты Фарма - 3.48%, Варез - 4.64% - это лишь классификация, а не повод занесения, просто выделил для себя, сколько из них содержали признаки того или иного сегмента. Плохие соседи (2.09%) - тоже фактор относительный, хотя всегда стоит смотреть какие ссылки продают рядом с вашей.

Второй срез - по классификатору, имеет погрешность, т.к. при анализе для занесения в черный список - анализировались конкретные внутренние страницы, а при нынешнем анализе учитывались только главные страницы сайтов - формат предоставления GBL SAPE.

Другие факторы и причины, это как неадекватное повышение цены на ссылки, так и постоянная недоступность и прочее, что я не могу четко классифицировать на отдельные сегменты, ведь анализ проводится постфактум, а не в момент занесения с четким правилом около каждого сайта.

В целом - я доволен фильтрами, которые используются, осталось только скорректировать их на основе сайтов, которые попали в те самые пару тысяч счастливцев в индексе, но при этом четко сидящих в моем черном списке. После коррекции можно будет более четко определять кандидатов на вылет.

Я думаю вам тоже стоит проводить такой мониторинг, чтобы корректировать свою стратегию закупок.

![]()

На данный анализ ушли сутки. Примерно 19 часов из которых пробивался яндекс (капча была поймана 1506 раз, анализ проводился с 1 IP-адреса), а затем и сами сайты, по очереди, не совместно. Здесь конечно мне пригодился полный комплект антивирусной защиты... ![]()

#1 by stanislav on 01/17/2011 - 17:13

Quote

фига себе 19 часов над статистикой))

#2 by MyOST on 01/17/2011 - 17:55

Quote

Все что для этого нужно - широкий канал интернета и защищенный компутер

Все остальное делается софтом, человек не нужен.

#3 by Андрей Мухачев on 01/17/2011 - 17:57

Quote

Отличный пост, спасибо! Про плохих соседей не очень понял, а в целом реально полезная аналитика.

#4 by Serg on 01/17/2011 - 21:08

Quote

Да уж база не маленькая и точность определения на уровне. А если не секрет какой софт использовался для создания такого обширного черного списка в начале (когда он создавался постепенно)...и какой для столь масштабной проверки сейчас?

#5 by getalifejerk on 01/17/2011 - 21:33

Quote

Много фармы, однако.

#6 by MyOST on 01/17/2011 - 21:59

Quote

getalifejerk, там не только сами сайты про фарму, там скорее чаще попадаются фарма-соседи (рядом стоящие сылки на фарму).

#7 by getalifejerk on 01/17/2011 - 22:07

Quote

А, ну тогда более логично. Но все равно как-то сапа и фарма у меня в голове не особо вяжутся

#8 by kladez-zolota on 01/18/2011 - 09:20

Quote

наверное нужно хорошо разбирать в сео, чтобы правильно делать запросы и фильтровать.

#9 by Арсений on 01/18/2011 - 12:26

Quote

А чем так плохи доноры с кол-вом страниц до 100?

#10 by MyOST on 01/18/2011 - 12:39

Quote

Как правило тем, что скоро они перейдут в более высокую категорию с кол-вом страниц до 45, а потом до 17 и выше.

Чем меньше страниц - тем больше ссылок на сайте стоит, в отношении к общему количеству страниц. Бывает что на сайте из 100 страниц стоит от 300 ссылок и более. Это плохо.

#11 by Кристина on 01/18/2011 - 13:34

Quote

А за сайты которые ни за что попали в черный список обидно.

#12 by MyOST on 01/18/2011 - 13:37

Quote

Таких в черном списке нету. Все попали "за что-то".

#13 by Альберт on 01/18/2011 - 14:07

Quote

А что вы думаете, по поводу сервиса xtool? Есть ли в нем смысл? Ведь существует же траст яндекса по отношению к сайтам, а они дают четкую цифру этого отношения.

#14 by веб дизайн on 01/18/2011 - 15:50

Quote

Sape уже давно исчерпала себя - нужно использовать прогрессивные альтернативы!

#15 by Ника on 01/18/2011 - 18:45

Quote

очень неплохой анализ, и статья полезная, особенно интересовала сапа

#16 by dimok on 01/19/2011 - 14:29

Quote

а ты смотришь отношение количества страниц в яндексе к страницам в гугле? если 100к100, то это еще не ахтунг, а вот 100к5000...

#17 by MyOST on 01/19/2011 - 14:47

Quote

Соотношение никогда не замерял в силу того, что при каджой новой проверке оно разное и частенько глючит.

Для меня и моих клиентов приоритетом стоит Яндекс - поэтому на него ориентир основной. У меня даже в договоре - платят за Яндекс, а все остальное в довесок продвигается, бесплатно

По опыту - на 1 страницу в гугле приходится 10 в яндексе, это нормально. Шаг в сторону - уже детальней смотреть нужно.

#18 by dimok on 01/19/2011 - 15:01

Quote

ну так я о том же: если в гугле страниц на порядок больше, чем в яндексе - повод задуматься. соответственно 100 страниц в яндексе - это ведь может быть, что сайт молодой и только начал индекситьтся, а может старый и начал выпадать из индекса.

#19 by MyOST on 01/19/2011 - 15:12

Quote

это пробивается довольно просто - молодой он или нет, двойной проверкой в "междуапье" в яндексе. В принципе на нормальном сайте за 2 недели прибывания и наличии множества страниц - он довольно быстро его проиндексирует.

Если сайт УГ - то вряд ли.

Такие выкладки можно делать для разных ценовых категорий. Если рассматривать ссылки до 5 рублей - то скорее можно второй раз не пробивать их, достаточно будет одного.

#20 by Gesha_zt on 01/20/2011 - 18:03

Quote

Я пользуюсь сапой, и на сегодня у меня всего куплено около 300 ссылок. При покупке вначале не обращал внимания на положение ссылок и на качество страниц, но с опытом начал отсеивать ссылки в футере, невидимые и т.д. Но это не больше 50% от всех доноров, это нормально или нужно больше отсеивать по каким-то параметрам? (сайты в основном адекватные).

#21 by vedan on 01/22/2011 - 03:25

Quote

Сапой периодически пользуюсь, но так как ссылок покупается не много, то все перебираю ручками. Однако один момент до сих пор напрягает - когда ссылки долго не попадают в индекс. Вот по этому поводу и вопрос: как быстро должна ссылка попасть в индекс и через какое время непопадания ссылки в индекс можно ее снимать и стоит ли?

#22 by palmistrys on 01/22/2011 - 13:08

Quote

У меня в сапе на одном сайте закуплено 1042 ссылки.

#23 by MyOST on 01/22/2011 - 19:58

Quote

Gesha_zt - в начале этого поста я дал ссылки на предыдущие публикации, там изложена моя позиция по другим параметрам проверки.

vedan - я считаю, что практически любая ссылка, при наличии 1-2 текстовых апдейтов в неделю, должна попасть в индекс за 15 дней. Вне зависимости от уровня вложенности. Если не попадает - нужно смотреть причину, может у сайта плохая индексация, может клоакинг, вобщем можно еще подождать дней 5, после смело заносить в черный список, т.к. сайт проблемный. Либо ждите и рано или поздно, при отсутствии действий со стороны владельца сайта, ссылка будет проиндексирована.

#24 by vedan on 01/22/2011 - 23:44

Quote

Спасибо за подсказку. Хотя такие сроки немного огорчают, получается, что грубо говоря, первый месяц - деньги на ветер.

#25 by Prada on 01/26/2011 - 14:22

Quote

Какая Альтернатива Сапе ?

#26 by макс on 01/26/2011 - 18:45

Quote

Вы молодец! Такую колосальную работу проделали, у меня бы не хватило терпения да и жалко тратить столько времени:) хочется пожать вам руку!

#27 by MyOST on 01/27/2011 - 06:02

Quote

Зачем искать альтернативу? Нужно комплексно подходить к делу, Майнлинк, Трастлинк + статейные

#28 by Ruslan on 01/27/2011 - 19:47

Quote

Спасибо за полезную инфу. Полезный мониторинг

#29 by Vetal72 on 01/28/2011 - 11:06

Quote

Закупаю ссылки по более-менее приличному фильтру и обычно из купленных 100% ссылок, процентов 30 отсеиваются по LF, Cn, TF и соответственно прямиком в GBL, еще процентов 30 по ВС, УВ, YP на отмену или в BL, 10% отменяю ручками ибо капец ГС, но сделанные так что подходит под все параметры плагина, как тока такие ГС в основную базу попадают. Остается 30% из которых 5-7% я отменю недели через 2-3 (2-4 апдейта) и возможно в GBL ибо страницы выпадут из индекса или кол-во ВС увеличится, или УВ опустится ниже 3, или цена сильно возрастет, еще 5-7 % ссылок отменю через недели 3-4 (4-5 апдейтов) из-за непроиндексированности ссылок (тоже в GBL), процента 2-3 уйдет в error без изменений. Остается 13-16% от всей купленной ссылочной массы, которые реально простоят какое-то продолжительное время. А теперь представьте сколько гавна в сапе)))

Мой GBL на сегодняшний день пока 28914 сайтов, работаю с сапой где-то пол года. Чекать GBL пока не буду, т.к новых сайтов ежедневно добавляется в сапу туева хуча, пока острой нехватки в донорах не ощущаю;)

#30 by Александр on 01/28/2011 - 15:13

Quote

А я не очень к сапе)) предпочитаю покупать вечные ссылки в том же гогетлинксе. Один раз заплатил и забыл, а сапа-сайты надо кормить ежемесячно

#31 by Денис on 01/28/2011 - 17:50

Quote

Sape уже не тот, что был раньше. Народ используйте биржи ГГЛ или трустлинк, помогает. Сам продвигаю этими биржами. К тому же я недавно загнал сайт в ГГЛ, теперь буду стараться в трустлинк попасть. НО говорят там одбор жёсткий. Не подскажите как в него попасть?

#32 by Егор on 01/29/2011 - 23:31

Quote

Нет, из Sape можно кое-что выжать, конечно. Просто площадочки там бывают, мягко скажем, не всегда нужные. Часто засоренные ссылками сайты или вовсе под фильтром. Что неудивительно, судя по статистике, даной выше.

Я вообще не сторонник бирж ссылок, так как это временная аренда ссылочной массы. Кончились денежки - и ваш сайт уже не в топе. Вдобавок при огромном количестве ссылок с некачественных ресурсов можно и самому под фильтр загреметь. Чего не хочется. Лучше продвижение статьями, или постовые в блогах покупать - они навсегда. Miralinks тоже может здорово помочь.

#33 by Salar De Uyuni on 02/01/2011 - 02:53

Quote

Я вот честно не пойму, зачем людям Сапа? Я и без неё своими ручками по 15 часов в сутки батрачя месяц подряд нарастил сайту 70 тИЦ.... кхм... да, теперь понимаю зачем людям Сапа =)

Но все равно, не страшно вам покупать ссылки на Сапе? Ведь даже в Гогетлинкс рядом с саайтами из сапы стоит огромный красный восклицательный знак, будто они чем-то чумным заражены =)

#34 by Scrat48 on 02/01/2011 - 15:21

Quote

А я вообще сапой не пользуюсь мне ближе RotaPost

#35 by Павел on 02/01/2011 - 17:05

Quote

Сапа хоть и стара, но все же выхлоп, хоть и не большой, но есть. Вообще по сути для белых проектов лучше закупать вечные ссылки. После последнего апа у меня многие саты потеряли в позициях, причем значительно. короче хрен поймешь новый алгоритм. и боротся с яшей становиться все сложнее и сложнее.

#36 by Елена on 02/02/2011 - 13:54

Quote

Что означает фарма? И чем она плоха для сайтов?

#37 by denis-chuprina on 02/02/2011 - 14:41

Quote

Думаю этот труд, а именно эти 19 часов проведнные над этой работой пройдет не зря. В банне да уж... очень большой процент

#38 by Ziky on 02/02/2011 - 17:05

Quote

Отличная статья - все наглядно показывает. Еще раз убеждаюсь, в правильности ухода с сапы на связку гогетлинкс+миралинкс. Да, это затратно, но и выхлоп Ты имеешь в разы больше, что Тебе принесет еще больше средств. А скупой пускай и продолжает платить по тысячу раз и не факт, что потом вообще оправдает эти средства.

#39 by крава on 02/03/2011 - 10:57

Quote

с помощью сапы можно нарастить своему блогу неплохое пузо. я лично так и делаю.

#40 by Фрилансер on 02/04/2011 - 06:47

Quote

Даже если учесть, что вся эта работа производится софтом - у меня терпения бы не хватило, хотя понимаю, что статистика нужная. Кто-то спрашивал что-такое фарма - вот я тоже не знаю!

#41 by MyOST on 02/04/2011 - 09:17

Quote

Сделать нормальный сайт, нарастить "пузо" и все.

Фарма - кратко, продажа мед препаратов (viagra, levitra...)

Дак зачем тут терпение? Загрузить список в программу, нажать 2 кнопки, уйти делать свои дела. По завершению нужно открыть результаты и посмотреть сколько чего - затем написал пост.

- затем написал пост.

19 часов - это время работы программы, а не мое (10-15 минут максимум)

#42 by Федор on 02/05/2011 - 22:24

Quote

Много всетаки ГС бороздят просторы интернгета

#43 by Elena on 02/05/2011 - 23:47

Quote

Объясните, пожалуйста, что значит "фарма"?

Второй не менее глупый вопрос - какой программой проводилась проверка?

#44 by MyOST on 02/07/2011 - 18:59

Quote

Elena - что такое фарма я описал чуть выше.

А софт - скоро будет доступен и для других пользователей, в данный момент находится на тестировании. Название пока держим в секрете

#45 by film-s on 02/08/2011 - 10:29

Quote

Фарма повсюду

#46 by Игроман on 02/08/2011 - 18:11

Quote

На счет вот этих 18.40% - почему вы решили, что это с большой вероятностью сайты под АГС? Многие вебмастера, занимающиеся, например, MFA, делают по 1-2 странички на сайте вообще. И как дополнительный доход просто добавляют их в сапу. И это очень даже неплохие ресурсы, потому что внешне хорошенько прокачиваются грамотно.

#47 by Юрий on 02/09/2011 - 16:11

Quote

Нигде не нашел вашего отношения к ссылкам в футере? (для покупки) Вроде перечитал все. Может ссылкой поможете?

#48 by Seo Dizain on 02/11/2011 - 07:04

Quote

Задела за живое статья... Как раз собирался прикупить ссылок на Сапе, а вручную проверять каждого донара, замучится можно. Надо тогда лучше действительно прикупить пусть меньше но более качественных и вечных ссылок, чем выкидывать деньги на ветер.

#49 by Seg on 02/11/2011 - 14:35

Quote

Да, определять качество площадки можно и, как показывает анализ последних публикаций по этой теме, нужно. Однако без автоматизированного софта не обойтись, потому как иногда объемы закупаемых ссылок большие.

#50 by маркетинг журнал on 02/11/2011 - 18:24

Quote

ждем релиза, судя по анонсу софт быстро наберет популярность

#51 by Олег on 02/12/2011 - 10:38

Quote

Жаль, что софт не всем пользователям доступен, а вот про соседей - это ты грамотно заметил. Спасибо. Учтем

#52 by MyOST on 02/15/2011 - 23:39

Quote

Хм... 1-2 странички и это не плохие ресурсы? Наверно я что-то не понимаю. Но смысла на заглушке покупать ссылки не вижу (пусть ей даже тиц прокачали прилично).

Более того - на этих сайтах не 1-2 странички были изначально, да и выборочная проверка это благополучно подтверждает - АГС.

Если в эти 18% попали несколько хороших сайтов по 1-2 страницы, я не особо огорчусь.

На данный момент не отсеиваю их. Да и площадок с выбором "вне футера" не так много.

#53 by Anton on 02/19/2011 - 16:19

Quote

Неплохой анализ. особенно заинтересовала Сапа)))

#54 by denis on 03/09/2011 - 12:25

Quote

да, очень хорошая статья, спасибо большое, особо за расклад по сапе

#55 by Sergey on 03/14/2011 - 23:22

Quote

ну сапа вообще системка неплохая на мой взгляд.Спасибо за анализ

#56 by Alex on 04/06/2011 - 13:38

Quote

Мдааа, мне кажется сапа только портит сайт, некогда ней не пользуюсь только ГГЛ

#57 by Max on 04/15/2011 - 14:24

Quote

Вот тут все пишут про ГГЛ - в нем тоже полных ГС полно, которые едва-ли модерацию проходят и помирают тоже достаточно быстро + при условии того что очень много заявок приходят сайты уже через несколько месяцев становятся переполненными ссылками (за исключением дорогих проектов от 200р или новостных сайтов с которых в принципе не покупаю).

#58 by Вячеслав on 05/20/2011 - 20:51

Quote

Ну не сапа портит сайт, а ГС находящиеся в ней. Поэтому надо конечно смотреть на какой сайт ссылаешься или с какого ссылку берешь.

К ссылкам в футере у меня отношение не очень хорошее, сразу понятно что сайт в сапе скорее всего. Я больше люблю ссылки ставить непосредственно в текст статьи, или же чуть ниже статьи с написанным текстом для ссылки

#59 by Alan on 01/28/2013 - 11:19

Quote

статья очень интересна, раньше ничего подобного не встречал