Сегодня уже не достаточно просто настроить фильтры и поработать "плагином" с настройками для отсева доноров, нужно копать глубже, чтобы ссылочная масса росла стабильно, без резких "телодвижений".

Обычный механизм работы человека покупающего ссылки - это работа с плагином, а именно начальная его настройка, а дальше уже легче, только контролировать. Я уже описывал проблемы сателлитщиков, при создании сеток, но сегодня не про них, а скорее против них, точнее даже не против вебмастеров, которые делают сайты под продажу ссылок, сколько против тех кто не в состоянии обеспечить безопасность сетки сайтов.

Если Вы находите определенную шаблонность решения, либо подхода к построению сайтов, то немедленно приступайте к анализу доменов, хотя бы по владельцам.

Находите сеть сайтов по владельцу - смело заносите все сайты в черный список, ибо если вебмастер не в состоянии обезопасить сетку от ее вычисления в 3-4 клика, то с большой долей вероятности она очень скоро выпадет из индекса.

Каким способом - не важно, либо настучит кто-то, либо поисковик ее определит.

Тут кто-то может поспорить - но ведь пока она в индексе, пока она работает - ее можно использовать!

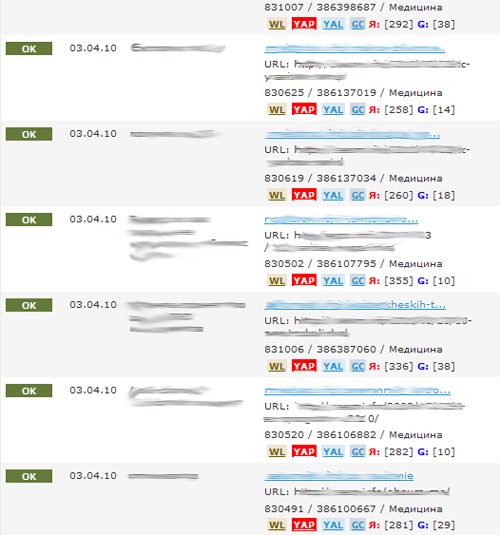

Без сомнений, можно, но в один "прекрасный" момент мы обнаружим вот такую картину - массовое выпадение этой сетки.

Для нас это значит одно - существенно (или не существенно, в зависимости от масштабов) сократилась ссылочная масса на конкретный проект. А это как раз те самые, не желательные последствия для сайта, которых нужно избегать.

При просмотре площадок, чаще анализируйте владельцев по whois, много интересного откроете для себя, посмотрите кто и чем занимается ![]() у кого масштабнее сетки и их основные ошибки.

у кого масштабнее сетки и их основные ошибки.

Анализируя чужие сетки сайтов - вы сможете избежать многих ошибок, при построении своей сети сайтов. Яндекс периодически устраивает "чистки" индекса, то что отсеивается на первоначальном этапе, как правило, вылетает (я отслеживаю периодически те сетки, которые вычислил и не купил там ссылки).

Только за сегодня при анализе ссылочной массы было отобрано 4 новых ключевых выражений для фильтра по урлу LF, теперь он составляет 58 ключевых выражений.

Только за сегодня было добавлено 9 новых ключевых стоп-слова для фильтра TF, теперь он составляет 76 ключевых выражений.

При этом фильтры отточены и почти исключают риск ошибок, они действительно отсеивают основной "шлак", который в будущем просто обязан вылететь из индекса поисковой системы с громадной долей вероятности.

З.Ы. нет - фильтры не покажу и не выложу, иначе приспособятся под них, придется больше отсеивать и менять ![]()

#1 by Антон Тыщенко on 04/09/2010 - 17:46

Quote

Вот какой интересный вопрос назрел:) Что будет если Оптимизатор купит ссылки на всех сайтах моей сетке? То получится линкованая сетка... При условии расположении всей сетке на 1 IP, сетку 100% на автомате кинут в бан... Вопрос, как можно избежать продаже ссылок одному человеку(не отказываясь от автоматического одобрения). И второй вопрос по сколько сайтов из сетки можно располагать на 1 IP, если торгуешь в ссылками в сапе?

#2 by MyOST on 04/09/2010 - 17:51

Quote

Бан от ПС никогда не накладывается по одному фактору, это всегда сумма, поэтому можно только теоретизировать на тему "если 1 купит в сетке".

Ссылочный граф для ПС - составить не проблема.

По IP вопросы - уже ранее в темах про сателлиты я оговаривал. Если уж 1 IP - то лучше с множеством левых сайтов, т.е. общий, а не выделенный.

Что касается безопасности сетки - не ссылайтесь на шлак, не принимайте все автоматом, отсеивайте шлаковые анкоры. Также отсеивайте "ценой", если это нормальный сайт, не средней.

Если ГС - то не отсеивайте ни ценой, ни чем иным, задача ГС - быстро окупиться и здохнуть

#3 by Школьнег on 04/09/2010 - 19:18

Quote

MyOST, не подскажешь, как в фильтре LF поставить запрет на урлы типа site.ru/2009/01/27?

Заколебали а то они.

#4 by MyOST on 04/09/2010 - 19:25

Quote

Крайне просто, на самом деле:

2009/01/|2009/02/|2009/03/|2009/04/|2009/05/|2009/06/|2009/07/|2009/08/|2009/09/|2009/10/|2009/11/|2009/12/

и так для каждого года можно

#5 by belyi05 on 04/09/2010 - 20:23

Quote

я даже ставлю просто 2008|2009 .. думал, у меня большой LF- фильтра, а оказалось всего 40 стоп-слов

#6 by seownik on 04/09/2010 - 22:54

Quote

Спасибо полезная статья! на днях тоже собираюсь ссылки прочистить... а то многие уже толку не дают!

#7 by Diner on 04/10/2010 - 14:48

Quote

Главное не делать резких движений!

#8 by Владимир on 04/11/2010 - 16:21

Quote

Спасибо за инфу будем чистить

#9 by Андрей on 04/13/2010 - 11:51

Quote

У меня в LF уже около 120 выражений

в TF около 80

#10 by MyOST on 04/13/2010 - 14:06

Quote

Речь о средневзвешенном фильтре? или всего 1 фильтр?

Дело в том, что фильтров много, есть жесткие - там несколько сотен

#11 by Андрей on 05/02/2010 - 17:31

Quote

Речь о средневзвешенном фильтре? или всего 1 фильтр?

-1 фильтр - все месте - там и жесткие и не жесткие. Разделять их отдельно как-то не хочется. Муторно потом использовать их по отдельности. Поочереди в плагин нужно вставлять...

#12 by MyOST on 05/02/2010 - 17:41

Quote

У меня их несколько, ибо ряд идет во все фильтры, а дальше в зависимости от стоимости ссылки я могу позволить определенные послабления или наоборот, закручивание гаек.

Т.К. по многим площадкам можно сразу сказать что вылетит с огромной долей вероятности.

#13 by Андрей on 05/02/2010 - 17:46

Quote

ну я тоже думал так делать, но... Допустим я хочу проверить со слабой модерацией по фильтру LF. Нужно зайти в плагин и вставить строку параметров. Потом я хочу проверить с жесткой модерацией - опять лезть в плагин и менять настройки LF.

Потом опять со слабой модерацией - опять все менять и т.д.

Александр, вы так делаете?

#14 by MyOST on 05/02/2010 - 17:49

Quote

Да, аналогичным образом, либо через скрипт - но это траф на сервере и есть ряд недостатков

Впринципе скоро будет гораздо легче, когда сейпмастер выпустит очередной релиз, там в разы интересней и легче будет (где-то через месяц).

#15 by ChErEp on 05/05/2010 - 00:12

Quote

ничо не понятно

#16 by Elektrod on 06/28/2010 - 15:15

Quote

Слушай, а если на обмен фильтры для LF и TF?

#17 by MyOST on 06/28/2010 - 15:32

Quote

Этот материал не для обмена и паблика, долго копился и постоянно пополняется.

Останется закрытым.

#18 by Elektrod on 06/28/2010 - 15:58

Quote

Ok, не вопрос)))

#19 by prostors on 06/29/2010 - 14:26

Quote

Добрый день.

Сателитчики учтут ошибки и исключат адалт (и тд) тематику со страниц, из названий стилей и тд. Это как минимум улучшит качество сателлитов.

Фильтр TF можно и показать.