Работа по покупке ссылок должна быть максимально автоматизирована, но для этого нужно провести большую подготовительную работу. Любой робот будет следовать вашим указаниям, но можно совершить ряд ошибок и испортить казалось бы конечную, отличную, идею.

Только кажется, что на бирже ссылок много ресурсов, на самом деле их нужно расходовать достаточно аккуратно. Поэтому вопрос о правильной классификации параметров для отсева ссылок встает довольно остро.

На самом деле, все фильтры, которые вы создаете – имеют довольно малую корреляцию с эффективностью, а если сказать точнее – то не выбор фильтра определяет его эффективность.

У меня в аккаунтах присутствует более 50 разных фильтров (если брать все аккаунты в сапе), включая клиентские, но при этом ни они определяют стратегию выбора донора.

Сайт с нулевыми показателями может сработать не хуже чем «с пузомерками», сайт не тематичный может сработать лучше, чем 100% верная тематика.

Если у вас нет большой выборки сайтов, по которой можно составить белые списки, то придется действовать немного иначе (кстати белые сайты часто становятся серыми и черными , их нужно проверять постоянно).

Основной упор – на формирование черных списков, для этого нужна четкая классификация параметров.

Я знаю достаточно людей, у которых за год-два работы черный список перевалил за 70 тысяч сайтов, при этом многие из них считают это абсолютно нормальным и они не заморачиваются с классификацией параметров.

Достаточно всего одного параметра для занесения площадки в черный список – это не правильный и не рациональный подход.

Чтобы собрать параметры для классификации – придется поработать руками и глазами, частично мозгом. А дальше все полученные результаты должны пойти в обработку автоматом, ведь автоматизация позволяет экономить кучу времени.

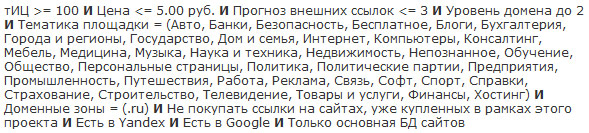

Первый барьер, который проходят сайты – это фильтр по URL (LF), которым мы пытаемся выявить заранее те сайты, которые имеют довольно большую вероятность к выпадению, а также не желательные страницы.

Как мы видим – у нас уже 2 классификатора:

- Вероятность бана/фильтра.

- Вероятность выпадения страницы.

Вероятность бана или фильтра могут иметь достаточное количество сайтов, например это может быть сайт-галерея, специально созданный под сапу, мы ввели параметры:

- Displayimage (галерея изображений)

- Thumbnails (галерея изображений)

- dn=photos (галерея изображений)

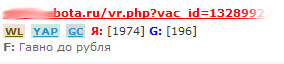

- .php?vac_id= (распарсенная база вакансий)

Отмечаем эти сайты и можем смело заносить их в глобальный черный список или черный список проекта.

Следующие параметры – не имеют четкой привязанности к характеристикам сайта, они имеют определенные характеристики страницы:

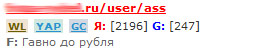

- User

- Tag

- Archive

Этими параметрами мы можем отсеивать системные страницы, которые могут быть в индексе, но будут рано или поздно выпадать, как содержащие дублированный контент, если это страницы тегов или архивов, либо системные страницы профилей юзеров, регистраций и прочего.

Этот классификатор не дает нам права метить площадку черным списком, ведь это не характеристики целого сайта, поэтому мы отменяем эти страницы, не добавляя их в черные списки, в следующий раз нам придут другие страниц этого сайта.

Надеюсь я доступно объяснил, что есть признаки сайта и страницы, их нужно четко различать, иначе будете "расходовать доноров" не правильно.

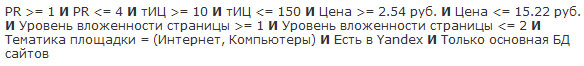

Второй барьер – количество страниц в индексе, здесь нужно быть аккуратным. Основная его цель – отсеять сайты попавшие под АГС, по количеству проиндексированных страниц.

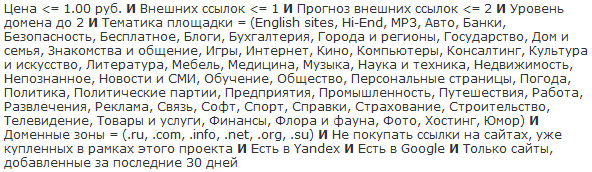

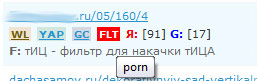

Третий барьер – контент фильтр или TF. Частично методику я уже описывал, мы можем фильтровать достаточно доноров по разным параметрам. Допустим на сайте есть "porno" и мы его заметили. Если не углубляться в детали – этот параметр достоин черного списка.

Но не каждый сайт содержащий параметры, перечисленные ниже, достоин черного списка:

- Keygen

- IFolde

- RapidShare

- Megaupload

Здесь мы можем либо отменить и нам предложат новые страницы, либо добавить в черный список конкретного проекта (BL), т.к. глобального он может быть и не достоин. TF я касался уже, поэтому не будем затрагивать его детально, отвечу на вопросы в комментариях, если будут.

Четвертый барьер – это количество внешних ссылок, количество внутренних, а также количество контента на странице (ВС).

Здесь все просто – нужно четко понимать, что это характеристика страницы, а значит не подходит под глобальный черный список, лучше всего отменять и нам будет предложена новая страница.

Последний этап, который мы проходим – это уровень вложенности (УВ), а также наличие страницы в индексе (YAP) и в КЭШе (YAC) яндекса. Это тоже характеристики страницы, мы не имеем права добавлять такие сайты в черные списки, т.к. делаем выводы лишь по одной странице.

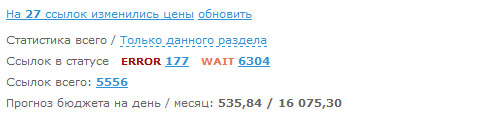

LF для черного списка – 35 сайтов, LF для отмены – 1766 сайтов.

H, Cn для отсева АГСных сайтов – 81.

TF для черного списка – 320 сайтов, TF для отмены – 840 сайтов.

ВС для черного списка – 15 сайтов, ВС для отмены – 2140 сайтов.

YAP и YAC для отмены – 230 сайтов.

В результате при сбалансированной работе у нас в черный список попал 361 сайт, а на отмену ушло 4076 сайтов. Значит из 5 тысяч 413 ссылок мы отсеяли 4976, оставив себе на рассмотрение более детальное 437 ссылок.

Если бы мы по-идиотски расходовали ссылочную массу и добавляли все в черные списки, без классификации факторов, то у нас получилось бы 4976 сайтов в черном списке только за 1 день.

По-моему – это не разумно, а я знаю многих людей, которые так делают, не разграничивая и не классифицируя параметры.

На сегодняшний день, в моем личном аккаунте, за несколько лет, накопилось всего 41 тысяча сайтов, которые отсеивались по очень жестким параметрам, если бы я огульно слал все в черный список, то было бы уже в раза 3-4 больше сайтов.

На аккаунтах заказчиков – меньше черные списки, но и работают они пока что меньше.

#1 by Vitaly on 06/23/2010 - 14:30

Quote

Как я понял - ссылки можно покупать не только тематические? Вообще, реально ли сказать, сколько ссылок с ТИЦ от 50 до 100 нужно чтобы получить ТИЦ, скажем 50? Или это частные случаи которые нужно рассматривать в таком же частном порядке?

#2 by SEOinSoul on 06/23/2010 - 15:07

Quote

Мне очень интересно, как ты по LF отсеиваешь

Проверяешь все целиком, а потом каждый урл просматриваешь? Или делаешь две проверки, одна которая для BL, а другая просто для отмены?

Или может как-то по-другому вообще...

#3 by MyOST on 06/23/2010 - 15:10

Quote

Опять все к тиц свелось

Да, модно покупать не тематику. Нет - сказать не реально сколько нужно ссылок для тица или для продвижения какого-либо запроса.

Все фильтры работают в 2 этапа, минимум. 1 - GBL, 2 - BL или отмена.

Доноры должны выдержать несколько фильтров - разной жесткости.

#4 by web-studia on 06/23/2010 - 17:06

Quote

перечитав множество форумов могу сказать одно что на тематику однозначно,результат будет лучше!

#5 by MyOST on 06/23/2010 - 17:56

Quote

Логичней было бы "продвинув много сайтов могу сказать...", а форумы - оно хорошо, конечно, но как-то не убедительно. Ведь вообще не известно кто и о чем там пишет и на чем основывается

#6 by web-studia on 06/23/2010 - 17:59

Quote

Да вот как раз скоро смогу сказать,как раз занимаюсь продвижением нескольких проектов:)

#7 by antojkee on 06/23/2010 - 19:54

Quote

Тематика влияет только тогда, когда сайт находится в YCA

#8 by chii on 06/24/2010 - 14:54

Quote

Имхо нетематику можно покупать при активном использовании околоссылочного. По крайней мере по моему опыту это так. Однословные ссылки (без окружения) с нетематики особо не работают.

#9 by DCDanton on 06/24/2010 - 16:27

Quote

Несмотря на то, что я сторонник вечных ссылок, было интересно почитать. Первая статья, где настолько ясно и детально расписывается процесс создания фильтров.

#10 by prostors on 06/24/2010 - 17:23

Quote

сайт у которого страницы то попадают, то исчезают из индекса (для фильтра по урлу) попадает под санкции? Происходит мелькание страниц - то одна в индексе, то другая, следовательно страница (пусть даже хорошая с нашей точки зрения) с нашей ссылкой может то попадать в индекс, то выпадать из него. Мелькание ссылок.

#11 by Andrei on 06/24/2010 - 17:39

Quote

Очень интересная методика! Спасибо!

#12 by Alex Shooltz on 06/24/2010 - 17:49

Quote

Интересно как Вы работаете именно с технической стороны, допустим:

1. Проверяете "LF для черного списка"

2. Изменяете настройки плагина винка

3. Проверяете "LF для отмены"

Или в плагине винка можно как-то сохранять различные настройки?

#13 by MyOST on 06/24/2010 - 18:08

Quote

Я сторонник мнения, что вечных ссылок нет

Возможно я не правильно понял вопрос, но фильтром по урлу никак не засечь мелькание донора.

Если нет скрипта, который делал бы это на автомате, то можно делать пошагово в плагине винка, либо сделать фильтры в http://www.sapemaster.ru/

Скоро они доделают программу, введут TF нормально и авторежим, я думаю что и скрипты отдельные не понадобятся Своя система автоматического продвижения - только задавать правильные параметры.

Своя система автоматического продвижения - только задавать правильные параметры.

#14 by prostors on 06/24/2010 - 18:11

Quote

ну конешно, меня проигнорировали

#15 by MyOST on 06/24/2010 - 18:32

Quote

Но выше я ответил, по Вашему вопросу. Если нет - задайте вопрос детальней, т.к. я его не совсем понял

#16 by Tanya on 06/24/2010 - 19:01

Quote

Большое спасибо за статью, очень полезна и информативна, помогла развеять много сомнений. Остался вопрос: " Насколько критично проверять страницу на индексацию в Гугле (GL), если продвигаемся в Яндексе? "

#17 by Денис on 06/24/2010 - 19:08

Quote

фига себе сколько ссылок.... вообще не заморачиваюсь с сапой).

#18 by Tanya on 06/24/2010 - 20:01

Quote

У меня еще вопрос по TF. Как правильно поступить при отборе слов в фильтр плагина с такими словами:"диплом", "реферат", "больничный" и т.п. В ГБЛ не внесеш - т.к. оно может всретиться как на нормальном сайте в тексте, так и на том, который допускает ссылки про покупку дипломов и т.п. Отменив размещение - можно лишиться нормальной ссылки.

#19 by MyOST on 06/24/2010 - 20:22

Quote

Если важен только яндекс - то можно не проверять, если гугл тоже, хотя бы "боком", то проверять.

Я не проверяю только по 1й причине - ссылок на всех проектах много, будет банить IP быстро при проверке.

при проверке.

Если у Вас не банит по IP - проверяйте.

К сожалению выхода, как такового нет, реально может встретится где угодно, проверять в ручном режиме отмеченные ссылки.

Данные "стоп-слова" не критичны, это не адалт тематика, все-таки.

Если ручной просмотр не вариант - попробуйте ограничить категории подбора ссылок.

#20 by Сергей on 06/24/2010 - 20:27

Quote

А можно подробнее про фильтрацию по контенту?

#21 by MyOST on 06/24/2010 - 20:29

Quote

а что именно интересует?

В статье я привел 2 ссылки по TF:

http://seom.info/2010/01/30/link-filtr/

http://seom.info/2010/04/28/sape-links/

#22 by Tanya on 06/24/2010 - 20:47

Quote

Большое спасибо! Подскажите пожалуйста, у Вас на скрине в этой статье, после абзаца "Третий барьер – контент фильтр или TF", стоп-слово "porno" выделено в рамочке. Вопрос" "Можно сделать так, чтобы стоп-слова каким-то образом выделялись при проверке?"

#23 by chii on 06/25/2010 - 00:12

Quote

оно и так выделяется в плагине винка. наводишь мышку на красный квадратик TF (так при проверке выделяются неподходящие страницы) и всплывает стоп-слово.

#24 by DSF on 06/25/2010 - 03:10

Quote

А какие в России есть биржы вечных ссылок?

#25 by bin112 on 06/25/2010 - 10:12

Quote

Вы тут пишите как правильно закупать ссылки.... а сами закупаете с откровенных ГС.

Например с моего сайта (optimisations.info).

Вроде ГС ГСом, всё криво и косо+домен info

#26 by Дмитрий on 06/25/2010 - 10:16

Quote

По моему опыту тематика = не тематике если она не присвоена сайту или сайт не в ЯК.

#27 by Алексей on 06/25/2010 - 11:27

Quote

Фильтр нормальный, но я считаю, что покупка тематических ссылок дает больший эффект, чем куча с разных сайтов

#28 by MyOST on 06/25/2010 - 12:25

Quote

Вечных ссылок не бывает, а так - Миралинкс, ГоуГетЛинкс, пожалуй

Знаете, не поленился, пошел посмотрел. Теперь по пунктам:

1 - ссылку я у Вас не купил.

2 - Вашу площадку мне предложила SAPA купить и она находится в статусе WAIT.

3 - проверку сайт не прошел (причем по нескольким фильтрам, уже сразу), ссылка там куплена не будет.

Так что не нужно раньше времени меня в чем-то обвинять, кроме того, я считаю вполне нормальным закупаться и на ГС, если он проходит проверку по моим фильтрам, другой вопрос, что ссылка там будет куплена максимум на 3 месяца (хотя не факт что проживет сайт столько).

#29 by spartak-ml on 06/25/2010 - 15:26

Quote

немогу понять разницу как работают постоянные ссылки? Подскажите пожайлуста

#30 by MyOST on 06/25/2010 - 16:41

Quote

Смотря что понимать под постоянными ссылками. Но если выбросить детали, то постоянные ссылки работают постоянно

Постоянные ссылки - это ссылочная масса, которая остается у сайта вне зависимости от вашего баланса в бирже и т.п.

Если проводить аналогии - то постоянные ссылки будут являться фундаментом, а стены вы будете стоить уже дальше на его основе.

#31 by Дмитрий on 06/25/2010 - 18:21

Quote

Просто из личного опыта: как ни настраивая отсев сайтов в Sape, все равно потом 90% ссылок никакого веса не передают. Мало того, 50% железно вообще не индексируются. Поэтому ручками работать приходится все равно.

#32 by MyOST on 06/25/2010 - 18:35

Quote

А каким макаром передаваемый вес измеряем?

#33 by Киноблоггер on 06/25/2010 - 21:06

Quote

> 5 тысяч 413 ссылок на подтверждение

Ужас какой, я б с ума сошел от такого. Вообще думаю с Сеопультом связаться, но сделать ручной режим. Стоит оно того?

#34 by MyOST on 06/25/2010 - 21:53

Quote

Проект не один в аккаунте, поэтому ссылок много

А тут

http://seom.info/2010/06/23/pokupka-ssylok/#comment-31641

Я уже описал - программу, которая сможет с такими объемами работать, экономя Ваше время.

Также у них планируется автомат выпустить - при следующем апдейте, ждем.

Ссылочные агрегаторы, стоит или не стоит, я не могу сказать, я не их активный пользователь.

#35 by adamovich.by on 06/26/2010 - 23:55

Quote

Лично я покупаю ссылки не только на тематических ресурсах. У меня у одного ресурса такая узкая тематика, что во всей сапе от силы сайтов 30 наберется

#36 by Andrey on 06/27/2010 - 07:52

Quote

К сожалению Сапа сейчас работает всё хуже и хуже, пора уходить в GGL

#37 by mo3ujijia on 06/27/2010 - 10:44

Quote

Саня, а как настраивать правильно фильтр LF ?

у меня он не работает, хоть чтобы там в поле не вводил... обидно аж

#38 by MyOST on 06/27/2010 - 11:22

Quote

Я думаю, если в ггл закупаться объемом нужным для сайта, то:

1 - не хватит площадок.

2 - не хватит денег.

Всегда - хорошо работает только комплексный подход.

На счет сапы - не согласен, просто детальней нужно к отбору площадок подойти.

Может старая версия плагина? Обновить тогда нужно, а что происходит и почему не работает? Может синтаксис нарушен?

#39 by ZZnOB on 06/27/2010 - 12:25

Quote

Спасибо за объяснения техники отбора ссылок, а то слил уже не одну 1000 рублей, а результаты мизерные. Мне вот только не совсем понятно как отсеивать по третьему барьеру, основываясь только на личный взгляд?

#40 by Максим АК on 06/27/2010 - 12:35

Quote

Фильтры те что описаны направленны на тиц или позиций?? Сапой тиц говорят просто поднять как то можно не понял про чтоу вас фильтры

#41 by Алексей on 06/27/2010 - 12:35

Quote

Пользуюсь плагином винка, просеиваю сайты на предмет индексации, параметры сайтов беру от тиц 10, pr без разницы, стараюсь выбирать тематичные ссылки. Ну и естественно на странице не более 1 ссылки

#42 by MyOST on 06/27/2010 - 12:36

Quote

По стоп словам?

Стоит определиться, ссылки какой ценовой категории просматриваются руками, а какая категория удостаивается только автомата, вот и все.

Ссылки категории до 2х рублей - руками не просматриваю, все остальное - уже частично да, дорогие - только руками. Также зависит от степени "нарушения", т.е. какое стоп-слово найдено.

Фильтр, что назван "тицовым", долбит по НЧ составляющей, чисто ТИЦ я не наращиваю, просто так назван и помогает как с НЧ, так и с тицом

#43 by Илья on 06/27/2010 - 18:20

Quote

А как вы классифицируете доноров при отборе? Есть ли разделение или полутона не для вас и вы видите только черное и белое?

Я также пользуюсь плагином винка при работе с sape - без него просто жестко было бы, несмотря на то, что объемы закупаемых ссылок у меня в разы меньше, чем у вас. После вашего поста задумался о разделении... До этого времени не прошедшие отбор площадки сразу отправлял в черный список.

#44 by Андрей on 06/29/2010 - 00:34

Quote

фильтр TF вы в БЛ значит отправляете, а не в ГБЛ ?

Вы рекомендуете перед Сn запускать Н, но при проверке Н нужно же еще вручную на эту кнопку тыкать потом, прямо в сапе ведь не пишется сколько страниц в индексе.

Зачем проверять YAC ? Какое его отличие от YAP ?

В плагине в опции Cn есть такая функция: если число страниц Я/Г или Г/Я больше определенного значения, то отмечать такие ссылки. Вы пользуетесь этим? Мне один весьма опытный сателлитчик говорил, что у него у Г-сателлитов чаще всего большой разрыв страниц в Яндексе и Гугле, а у белых проектов число страниц в Я и Г примерно одинаковое.

Я сейчас выставил в настройках коэффициент 3 для данной функции, что не проходит пока отправляю в БЛ, а потом думаю обнулить БЛ. Т.е. сначала покупаю лучшие ссылки, а когда такие закончатся по данному фильтру, то обнуляю БЛ и буду покупать уже без отсева разности страниц в Яндексе и Гугле.

НА сколько проектов и сколько ключей такой объем ссылок закупается, если не секрет?

И еще по другой теме хотел спросить у вас. Насчет составления анкор-листа. Я постоянный читатель блога, но вроде не встречал вас про анкор-лист ничего...

#45 by Squal on 06/29/2010 - 09:48

Quote

У меня вот что-то сомнения в моем LF фильтре. Стоит ли такую ссылку по УРЛ пропускать?

/index.php?option=com_virtuemart&page=shop.registration&Itemid=87&vmcchk=1&Itemid=5

#46 by MyOST on 06/29/2010 - 10:31

Quote

Андрей,

TF по классификации - часть может уйти в GBL, часть в BL, часть на отмену. Вопрос только в классификации параметров.

"Зачем проверять YAC ? Какое его отличие от YAP ?"

YAC - наличие страницы в кэше, если ее нет в кэше, то какой толк от нее, точнее от того что YAP покажет, что адрес в индексе

"Вы рекомендуете перед Сn запускать Н, но при проверке Н нужно же еще вручную"

да, нужно если про плагин винка говорим

"В плагине в опции Cn есть такая функция: если число страниц Я/Г или Г/Я больше определенного значения, то отмечать такие ссылки. Вы пользуетесь этим?"

Да, конечно, чтобы отсеивать сайты под АГС или тупо забаненные.

"Мне один весьма опытный сателлитчик говорил, что у него у Г-сателлитов чаще всего большой разрыв страниц в Яндексе и Гугле"

Оно, конечно верно, но ставить соотношение я стал. Все просто, если брать разбор, то на 10 проиндексированных в яндексе, должна быть 1 в гугле, если разрыв больше - то это повод задуматься о качестве сайта.

Такой разрыв я для себя определеил - на основе тех сайтов, что просматривал и делал.

Соотношение - порой может сыграть злую шутку, гугл чудит с показателями иногда.

Одинаковые показатели в гугле и яндексе - только на малостраничных сайтах, на остальных, в подавляющем большинстве - разрыв есть.

"то обнуляю БЛ и буду покупать"

Может я чего упустил, но ведь BL проекта мы не видим и не можем его обнулить. Если видим - то покажите как, я такой функции не знаю, тольго GBL

"НА сколько проектов и сколько ключей такой объем ссылок закупается, если не секрет?"

на этом аккаунте, с которого скрин, там 42 проекта, и где-то 3-5 не активные сейчас, ввиду сезонности

"Насчет составления анкор-листа" правда там по буржунету, а по рунету смысла писать нет - слишком успедненные данные получатся и материал быстро устареет

правда там по буржунету, а по рунету смысла писать нет - слишком успедненные данные получатся и материал быстро устареет

а вроде нашли материал уже

Дело в том, что часто под такими урлами скрываются различные варианты сортировок "по цене" "по еще чему-то", а сортировка - это системная страница, которая рано или поздно выпадет, поэтому на ней я не хочу покупать.

Т.К. стало много сортировок появляться, я поступил чуть проще, ввел & в параметр для фильтра урлов, но я четко осознаю, что он также часть друпала и ждумлы может отсекать, которые не являются сортировками.

#47 by Андрей on 06/29/2010 - 10:39

Quote

"Оно, конечно верно, но ставить соотношение я стал. Все просто, если брать разбор, то на 10 проиндексированных в яндексе, должна быть 1 в гугле, если разрыв больше - то это повод задуматься о качестве сайта."

Значит коэффициент у вас там 10 стоит.

И что не проходит в ГБЛ отправляете или просто отменяете?

Насчет БЛ: сделал скрин, но не знаю как в коментах тут прикрепить его. В общем когда находишься внутри проекта вверху там горизонтальное меню - тексты, размещено, авторежим ... и там же находится BlackList, тобишь БЛ

#48 by MyOST on 06/29/2010 - 10:43

Quote

"Значит коэффициент у вас там 10 стоит."

Нет, там стоит - если меньше 15 страниц в яндексе, то в ГБЛ (ибо АГС)

"Насчет БЛ:"

Ох, охренеть... Сколько лет сапой пользуюсь, только увидел

Спасибо

#49 by Андрей on 06/29/2010 - 10:49

Quote

"Нет, там стоит - если меньше 15 страниц в яндексе, то в ГБЛ (ибо АГС)"

дык я про другое спрашивал... В плагине там, где не менее N страниц в яндексе и гугле ище ниже написано: "количество страниц в Гугле и Яндекс различается в X раз и более"

Вот про этот Х-праметр я имел ввиду. Выставляете ли вы его, если да, то какой? И что с площадками такими? ГБЛ? БЛ? или просто на отмену?

Я выше уже писал - сначала ставлю Х=3 и все в БЛ отправляю, как закончатся площадки обнуляю БЛ и убираю параметр Х вообще.

#50 by MyOST on 06/29/2010 - 10:50

Quote

Да, я выше отписал - соотношение не использую.

Есть четкий параметр - сайт попал под АГС, или бан, его можно добавить в блэк лист, а по соотношению - слишком часто будут страдать сайты, у которых все хорошо.

#51 by Андрей on 06/29/2010 - 21:55

Quote

"Насчет составления анкор-листа" правда там по буржунету, а по рунету смысла писать нет - слишком усредненные данные получатся и материал быстро устареет

правда там по буржунету, а по рунету смысла писать нет - слишком усредненные данные получатся и материал быстро устареет

а вроде нашли материал уже

>>почему нету смысла писать по рунету для Яндекса? В чем смысл слова "усредненные "? И почему быстро устареет материал, неужели Вы каждые полгода меняете что-то так координально в анкор-листе? По-моему материал будет долгое время актуален, а если и будет пропадать его актуальность, то постепенно и только в некоторых моментах, а не то что все сразу вдруг станет неактуально.

#52 by Squal on 06/30/2010 - 11:15

Quote

А плагин Винка не глючит? просто в LF вбил стоп-слова, то есть тот же амперсант, но он не подсвечивает ссылки, которые в себе содержат "&", такую, как выше я привел, например.

#53 by Tyuir on 07/01/2010 - 14:50

Quote

А поделиться своим блэк листом можете?

#54 by Dimasik on 07/03/2010 - 13:50

Quote

Отлично разжованный метод, хотя для новичков или просто для своих собственных белых проэктов сапа все же не ахти, особенно со всевозможными санкциями от Яшки. Покупка вечных с того же гогетлинкса надежнее, хотя понятие "вечная" это условно..)

#55 by Cowboy Marlboro on 07/03/2010 - 17:34

Quote

Спасибо за подробно описанный материал. Буду использовать данную методику в работе.

#56 by Kras on 07/04/2010 - 20:29

Quote

Не ужели еще сапа работает и дает такой эффект. Я думаю что еще пару лет и этой биржет не будет, потому что Яндекс сейчас какой то становиться не адекватным

#57 by Анатоль on 07/09/2010 - 12:22

Quote

У меня другой подход: надо не черные списки составлять, а просто для каждого проекта изучать ссылки. Потому что тысячи сайтов в биржи добавляются - и все если добавлять в блэклист... устанешь в общем.

#58 by Дмитрий on 07/12/2010 - 16:46

Quote

Плагин Винка конечно незаменимая вещь и пользуюсь очень многими кнопками для отсева донора. Спасибо за статью, лишний раз подтвердил свои наработки.

#59 by burunduk on 07/13/2010 - 13:41

Quote

Привет, Саша, ты опять палишь темы , хотя основной массе это все равно не поможет.

, хотя основной массе это все равно не поможет.

кстати мог прямо назвать тех "людей, которые так делают, не разграничивая и не классифицируя параметры", но как показала практика так то же можно, просто классификация идет на уровне перепроверить потом (через 2-3 месяца), если он будет в индексе и будет соответствовать установленным условиям то он покинет гбл

как показала практика больше 60% попадают в бан пс

и еще если сайт продает ссылки на бирже и у него достаточно специфичные (tag, .....), то как правило долго он не проживет

#60 by MyOST on 07/13/2010 - 13:49

Quote

Леха, ты не катишь под "людей, которые так делают" у тебя отдельная тема с отдельной наработкой в этом плане. Не про тебя речь

#61 by ekarnakov on 07/19/2010 - 15:44

Quote

>Если нет скрипта, который делал бы это на автомате, то можно делать пошагово в плагине винка, либо сделать фильтры в sapemaster.ru

Поделитесь пожалуйста этим скриптом:)

#62 by uptime on 07/26/2010 - 15:03

Quote

Привет!

Посоветуй пожалуйста, стоит ли закидывать сайт в бан (GBL), если после апа ссылка с этого сайта проиндексированна, но прироста в позициях нет или наоборот минус?

Оцениваю так: смотрю в tools.promosite.ru до какого числа учитывались ссылки, отсеиваю их по анкору в сапе, проверяю на индекс и сверяю с результатом. Если ссылочный прирост не дал плюса в позициях, сайты в бан.

Или такие ссылки могут быть учтены позже, либо просто их влияние оказалось не заметным (запросы нч, максимум сч)?

#63 by Felix on 07/26/2010 - 19:33

Quote

Такой вот вопрос в плагине есть функция отмечать сайты если количество страниц в индексе гугла и яндекса различаются в N раз.

Кто как использует эту функцию? И стоит ли на это обращать внимание при закупе ссылок ?

#64 by 6uoncuxo3 on 08/27/2010 - 19:48

Quote

LF->BC->TF->YP->H->Cn. YС после этого уже и не нужно, почему так, я сам в раздумьях.

Старательно не трогаю Яшу до поры YP. Хотел бы услышать Ваши комментарий, Александр.

#65 by helen on 09/09/2010 - 15:17

Quote

Тематические ссылки обычно дают лучший результат, вот только Яндекс не любит, когда сайты ссылаются друг на жруга, хотя и нетематика при перекрестном обмене тоже дает результат, интересно было бы посмотреть колличественное соотношение результатов при тематическом обмене и нетематическом, перекрестном и прямом...

#66 by derbyshire on 09/11/2010 - 13:52

Quote

Александр!

Получается, что плагин Винка удобнее чем, CS SapeMaster?

Как можно проделать ту же работу, только через sapemaster? И позволяет ли интерфейс софтины это реализовать?

#67 by MyOST on 09/11/2010 - 14:04

Quote

derbyshire, плагин винка нужен для подбора параметров и тестов этих параметров. А сейп-мастер для автоматической проверки, ежедневной.

Т.Е. через плагин реально удобно тестировать разные варианты параметров. Через программу - внедрять их.

#68 by Mike on 09/13/2010 - 11:20

Quote

Что-то маловато инфы для статьи подобной тематики. Все очень расплывчато. Афтар - больше символов и язык немного попроще. Добавил в закладки;)

#69 by vital on 09/14/2010 - 14:00

Quote

Почему-то не работает фильтр LF. Ставлю простую фильтрацию: tag|, плагин выделяет красным все ссылки, хотя tag в урле и не пахнет(. Если ставлю все фильтры - то же самое. Версия плагина 2.6.2. Не знаете в чём может быть проблема?

#70 by MyOST on 09/14/2010 - 14:23

Quote

vital - последний символ | ?

если да - то уберите его, скорее всего проблема в этом

#71 by Андрюха on 09/14/2010 - 22:31

Quote

Александер, не подскажите тут ситуацию. Как управляться с плагином Винка (или может тут другой инструмент будет лучше), если у меня есть фильтры, где до 2 ВС, и есть фильтры. где до 4 ВС.

Эти фильтры работают для одного урла. Если в плагине поставить отмечать ссылки, где ВС>2, то отметятся и ссылки по фильтру ВС до 4, а этого нельзя допускать. Если поставить в плагине отмечать больше 4, то тогда не проверятся ссылки по фильтру до 2 ВС.

Я снимал галки проверки контента и внутренних ссылок, ставил "отмечать, если ВС больше чем заявлено" и потом руками пробегал и где нужно снимал ссылки. Но очень не удобный способ. + потом еще нужно отдельно выставлять в проверке ВС количество контента и внутренних ссылок и запускать фильтр ВС еще раз.

#72 by MyOST on 09/14/2010 - 22:44

Quote

Я думаю, что винком тут не обойтись.

http://seom.info/2010/07/07/sapemaster/ - и отстраивать систему фильтров.

Винк - для ручного режима по сути, для определения параметров, а повседневную работу по этим параметрам должна делать автоматика.

Но если про винк, то нужно просто более правильную структуру построить.

1 проект/урл - ставится под 1 фильтр, другой под другой фильтр. В результате не будет той самой свалки, в которой ВС и 2 и 4.

#73 by Андрюха on 09/14/2010 - 23:02

Quote

а sapemaster работает с компьютера, это же прога, а не серверный скрипт? Да и трафик будет жрать, инет будет подтормаживать...

Быстро работает с компьютера ? (или все же не с компа?)

#74 by seogod on 09/15/2010 - 15:00

Quote

1.) снимаете ли вы ссылки которые непроиндексированны какой-то период? (если ДА то через сколько?)

2.) какие нибудь внешние меры по ускорению индексации ссылок проводите?

3.) на количество внутренних ссылок внимание обращаете?

p.s. если позволите отступиться от темы. Не подскажите у вас есть помощник? или вы один работаете?

#75 by MyOST on 09/15/2010 - 15:31

Quote

Андрюха, не тормозит (но компутер мощный).

не тормозит (но компутер мощный).

сейп мастер работает с компа, ну ест трафик, проблем не наблюдаю

Серверный скрипт есть, например, у некстап - из публичных, что мне известны ( http://nextuper.nextup.ru/ ).

Как сервис - есть еще драйвлинк.

seogod,

1 - в зависимости от количества апдейтов у яндекса, от 15 до 25 дней жду индексации.

2 - года 2 как не предпринимаю никаких подобных действий.

3 - да, на данный момент не более 100.

P.S. один.

#76 by seogod on 09/16/2010 - 08:59

Quote

Александр, подскажите пожалуйста а какая часть ссылок которая в белом списке попадает со временем в чёрный?

#77 by MyOST on 09/16/2010 - 11:58

Quote

seogod,

к сожалению на этот вопрос ответить не могу, т.к. не веду белых списков, только черные.

#78 by seogod on 09/16/2010 - 12:33

Quote

сайты на которых ссылки не проиндексировались за 25 дней в блэк лист попадают?

#79 by MyOST on 09/16/2010 - 12:38

Quote

seogod, очень сильно зависит от ценовой категории (фильтра).

Первое, в чем нужно разобраться - это ПОЧЕМУ она не проиндексировалась, если апдейты были. Нужно выявить признаки таких сайтов, чтобы больше не закупаться на них.

Если это дешевый ГС для НЧ - то он имеет все шансы попасть в черный список (исхожу из того, что этот ГС по-любому попадет в черный список в ближайшие 2-3 месяца, так что раньше или позже - это уже детали).

#80 by derbyshire on 09/19/2010 - 18:50

Quote

Получается, что при покупке ссылок - CS Sapemaster ты не используешь, а юзаешь для проверки закупленных ссылок?

Тогда, ждем статью "Проверка закупленных ссылок через CS Sapemaster"

#81 by MyOST on 09/19/2010 - 22:08

Quote

derbyshire, сейпмастер нужен для ежедневной проверки наличия ссылок, доступности сайтов, а также быстрого отсева по ранее введенным параметрам (я его так использую). + Там режим автомата тестируется

http://seom.info/2010/07/07/sapemaster/

#82 by meraleks on 10/01/2010 - 12:15

Quote

-"если мы четко видим 500 внутренних ссылок на странице или больше, то здесь можно и в черный список добавить"

-"ВС для черного списка – 15 сайтов, ВС для отмены – 2140 сайтов"

Помоему здесь есть некая заковырка. Т.е. что бы не добавить сайт в ЧС нам надо просмотреть 2140 сайтов?

#83 by MyOST on 10/01/2010 - 12:17

Quote

meraleks - смотреть нам их не нужно, мы отменяем и нам будет предложена другая страница с другими параметрами

#84 by Юрий on 11/17/2010 - 10:01

Quote

Подскажите, плз. новичку - что хуже купить 4-ю ссылку на странице 3-го уровня или 3-ю, но в футере? ) не сочтите это за бред:))

) не сочтите это за бред:))

#85 by Король Кухни on 12/07/2010 - 18:07

Quote

Покупка ссылок сейчас, не знаю к радости или к сожалению, является главным (эффективным) способом поднятия тИЦ, но не все сайты качественные, как верно подмечено в этой статье.

#86 by Diffio on 01/02/2011 - 00:39

Quote

Благодаря этому посту только что купил Sape Master

Теперь буду совмещать со знаниями из вашего поста.

Спасибо!

#87 by Seo on 01/06/2011 - 10:57

Quote

Александр скажите пожалуйста во сколько раз не должна превышать разница проиндексированых страниц в Гугл и Яндекс. 3-5-10 раз?

#88 by MyOST on 01/06/2011 - 21:03

Quote

Seo:

Александр скажите пожалуйста во сколько раз не должна превышать разница проиндексированых страниц в Гугл и Яндекс. 3-5-10 раз?

К сожалению этот параметр порой может быть слишком не корректен, поэтому я его не использую. Но обычно 10 в яндексе к 1 в гугле - все что выше, в шлак.

Но повторюсь - может быть крайне не корректным показателем.

#89 by Oleg on 01/11/2011 - 17:56

Quote

А почему ничего про возраст доменов не сказали? Мне кажется что это один из ключевых аспектов при подборе доноров. Или я не прав?

#90 by MyOST on 01/11/2011 - 18:42

Quote

Oleg - возраст домена ничего не говорит о возрасте сайтов. Тем более многие сателлитщики дают время для того чтобы их сателы "отстоялись"

#91 by dima on 01/11/2011 - 20:33

Quote

Полностью с вами согласен, домен можно зарегистрировать, а сайт на него повесит хоть через год

#92 by Oleg on 01/12/2011 - 13:47

Quote

"Отсоялись" - да, но если они отстаивались с сайтом или заглушкой, то так называемый "траст" у этих сайтов уже есть, хоть и небольшой. Если указать, скажем возраст в 2-3 года, то тут уже не будет таких сайтов которые "отстоялись":) Ведь тупо проплачивать домен без сайта 2-3 года никто не будет. Зато такие сайты уже прошли "естественный отбор" у ПС и шанс того что они попадут под фильтры значительно ниже чем у сайта которому пол года - год. Да и ТИЦа такие сайты поболее передают, как мне кажется. Для десятки обычно хватает 250р в месяц с ценой ссылки до 3р. На сайтах до года эта цена раза в 2 выше.

#93 by MyOST on 01/12/2011 - 14:00

Quote

Oleg - у меня домены отстаиваются и по году и по два и более, некоторые.

Про траст - не верно, траст тут не при чем, траст от заглушки не получается, речь идет только о возрасте индексации первой.

#94 by _alk0g0lik_ on 01/26/2011 - 17:08

Quote

Александр, а вы уверены, что если вы нажали "отменить ссылки", то к вам в следующий раз на этот проект с этого донора придет другая ссылка? Я поступаю проще, я их всех в BL отправляю. На этот проект с донора уже ничего не придет, а вот на другие придут.

И еще вопрос, а вы знаете как быстро поменять настройки плагина? А то мне в день тоже по 4К ссылок приходит и для разных проектов разные настройки, а постоянно менять настройки вручную задалбливает.

И как вы смогли подвести статистику "На сегодня мне пришло 5 тысяч 413 ссылок на подтверждение, результаты таковы"?

#95 by MyOST on 01/27/2011 - 06:06

Quote

_alk0g0lik_,

На счет "отменить" я точно уже не помню, толи на форуме сапы, толи на конфе у саповцев спрашивал, где внятно объяснили что придет именно новая ссылка и засовывать в черные списки не нужно.

Проверить достаточно просто - внести 1 сайт в избранное, поставить фильтр, чтобы по избранному предлагал на полуавтомате и несколько раз отменить предложенные результаты в принципе станет все предельно ясно.

в принципе станет все предельно ясно.

К сожалению у сапы BL не проекта, а урла - т.е. для проекта будут приходить они. Т.Е. есть СОВСЕМ жопа в виде GBL и ее половинка в виде BL, а вот нужного состояния в виде центральной части - которая чисто под проект BL делает - нету.

Быстро поменять настройки плагина никак нельзя, все-таки это деревянная вещь, но мы уже делаем гибкую и стойкую - она на стадии альфа-тестирования. Собственно часть тестов проводилась на основе скриптовой выборки и часть софтверной.

#96 by Андрей on 01/27/2011 - 10:38

Quote

"На сегодня мне пришло 5 тысяч 413 ссылок на подтверждение"

Получается. что вы отменили больше, чем пришло в заявки. Если посчитать все отмены, то в сумме это 5 427, а заявок всего то было 5 413. Где собака зарыта?

Вообще хотел посчитать таким образом какой процент из заявок вы подтверждаете.

#97 by MyOST on 01/27/2011 - 14:07

Quote

Андрей - собака зарыта в пересечении или не верном подсчете в софте, т.к. часто выгрузка с сапы в софт и то кол-во которое видно в сапе - имело и имеет расхождение. Сейчас, спустя время, мне сложно сказать где потеряна часть

А скорее просто выпало из подсчета, т.к. ниже описана ситуация как раз точная что из 5.413 к рассмотрению осталось лишь 437.

Процент подтверждения не высок, от 2 до 5% стандартно, редко выходит больше, в примере к статье - район 8% на рассмотрение дальнейшее ушло. Разумеется часть дальше не пройдет остальные проверки.

#98 by илья on 03/23/2011 - 15:24

Quote

александр, как считаете, тиц клееный - тоже в гбл сразу?

#99 by MyOST on 03/23/2011 - 15:34

Quote

Не ориентируюсь на тиц, поэтому и не проверяю его. От сайта зависит все, гбл или нет

#100 by илья on 03/23/2011 - 15:37

Quote

ну то есть, домен с клееным тицом, если устраивает по остальным параметрам, то можно брать?

сие есть ложь, что домен с клееным тицом не передает вес?

ваше отношение к уник-неуник?

насколько это серьезный фактор. понятно, что индексится и с неуника хорошо, если сайт нормальный. но вот насколько влияние зависит от этого?

спасибо за ответы большое.

#101 by MyOST on 03/23/2011 - 15:58

Quote

Да, если устраивает - можно брать.

Дать точный ответ по передает или нет - не могу, т.к. для этого нужен актуальный эксперимент, который необходимо ставить. Т.К. на тиц не обращаю внимания практически - то и выборки такой нет.

Кроме того - как замерить передачу веса? И в чем его измерять?

К неунику отношусь терпимо. Менее терпимо при цене на ссылку от 6 рублей. Еще менее терпимо при цене от 10 рублей. Дальше - зависит от сайта.

#102 by Алексей on 04/09/2011 - 10:04

Quote

Александр а вы как то отсеиваете сайты добавленные в сапу по времени добавления в систему и по количеству исходящих ссылок с домена?

#103 by 3zor on 05/06/2011 - 13:38

Quote

А можете поделиться своими LF и TF фильтрами?

#104 by Димон on 05/19/2011 - 16:53

Quote

Хм.. интересная статья.

Но не лучше ли покупать ссылки вручную, с ручным фильтром пощадок?

#105 by valet on 06/17/2011 - 03:43

Quote

.

А про остальные проверки нельзя ли поподробнее

#106 by DexuZz on 07/12/2011 - 11:53

Quote

Пользуетесь ли Вы сторонними сервисами, по определению траста донора и качества покупаемой ссылки, к примеру xtool.ru, либо ограничиваетесь личными оценками донора?

#107 by MyOST on 07/12/2011 - 12:19

Quote

Это наработки, которые делаются достаточно долго, чтобы их выкладывать.

Тем более нужно уметь находить эти параметры, т.к. появляются новые, а старые видоизменяются.

Все зависит от количества проектов и количества продвигаемых запросов.

Если это не 1 проект и не 100 запросов, а проектов 10-30, причем на каждом не менее 500 запросов, то ручная работа должна быть сведена к минимуму, только для дорогих ссылок.

Не менее 100 дней домену. Колво исходящих продажных - чем меньше, тем лучше. Все зависит от площадки.

#108 by Алекс on 07/06/2012 - 21:27

Quote

Александр, на основе экспериментов некоторых сео блоггеров, сайты продвигаемые сапой под Гугл очень сильно просели после прихода Пингвина? Что скажете по этому поводу Вы?