Google стал более разборчивым в поисковой выдаче. Но очень интересно посмотреть в чем же? Очень много людей уже изучали процесс индексации Google, даже экспериментировали над ранжированием и факторами влияющими на него, но мы до сих пор удивляемся тому насколько умен Googlebot сам по себе.

Для начала мы познакомимся с некоторыми теориями и принципами работы Googlebot. Некоторые результаты представленных ниже исследований под вопросом и должны быть проверены на сотнях доменов, но все же это должно натолкнуть вас на некоторые идеи.

Скорость работы поискового паука

Первое, что мы решили протестировать, это утверждение Мэтта Каттса: "... количество страниц, которые мы просматриваем напрямую зависит от PR вашего сайта".

Это привело нас к одной из самых главных проблем многостраничных сайтов — к проблеме индексации всех страниц.

Для эксперимента мы взяли домен без истории (никогда нигде ни регистрировался, ни одного бэклинка). Затем на этом домене мы создали страницу с 250 ссылками, ведущими на страницы с еще 250 ссылками и т. д. Ссылки и URL были пронумерованы от 1 до 250 в таком же порядке, как они идут в исходном коде.

Мы добавили URL в поисковик с помощью "addurl". Так как домен не имеет ни одной обратной ссылки (бэклинка) следовательно у него нет PR, либо он совсем ничтожен. Если же слова Мэтта Каттса действительно являются правдой, Googlebot должен практически сразу же остановить индексацию данного домена.

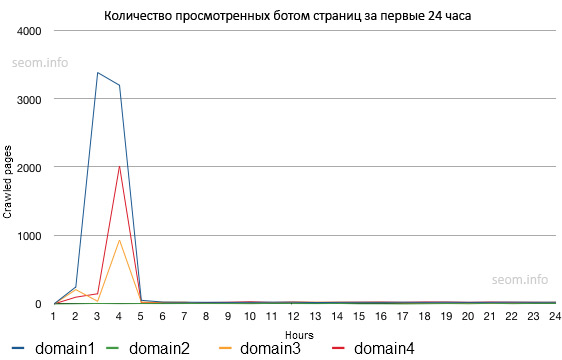

Как видно из диаграммы, Googlebot начал просмотр сайта со скоростью примерно в 2500 страниц в час. Через три часа он замедлился до 25 страниц в час и с такой же скоростью продолжил просматривать сайт на протяжении последующих месяцев.

В подтверждение данных результатов мы проделали то же самое с двумя другими доменами. Повторные тесты показали примерно похожие результаты. Единственное различие — меньшая скорость просмотра вначале.

Влияние карты сайта

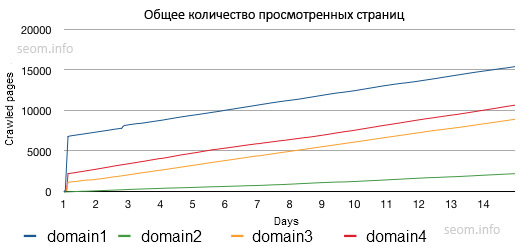

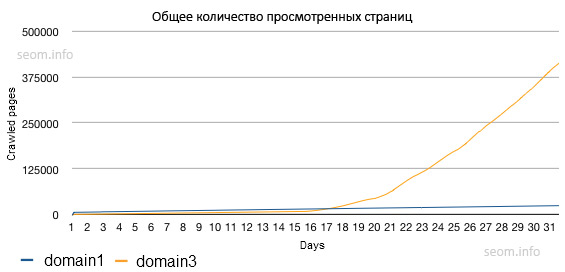

Во время тестов, карта сайта показала себя как мощный инструмент влияния на поискового паука. Мы добавили карту сайта с 50 000 не просмотренными поисковиком страницами. Googlebot поместил ссылки из карты сайта выге всех остальных в очереди на просмотр роботом.

Это означает, что эти страницы будут просмотрены быстрее всех остальных. Также карта сайта увеличивает скорость просмотра страниц в час. Вначале, скорость просмотра была 20-30 страниц в час.

После того, как была загружена карта сайта скорость увеличилась до 500 в час. Через несколько дней, скорость увеличилась до 2224 страниц в час. Средний рост скорости просмотра страниц сайта поисковиком составил 4630.27%. Причем, увеличилась скорость просмотра страниц не только из карты сайта, но и всех не включенных в нее страниц.

Нужно отметить, что Google внезапно увеличил скорость просмотра страниц сайта. Google, возможно, придает большее значение ссылкам на страницы, расположенным в карте сайта.

А теперь давайте вернемся к утверждению Мэтта Каттса.

Помните, что PR увеличивается в геометрической прогрессии (ссылки, необходимые для получения следующего уровня PR). Другими словами, не задумывайтесь о PR, даже если у вас огромный сайт. А еще лучше сказать — не воспринимайте близко к сердцу все, что говорит Мэтт.

Количество ссылок

Вот что говорит Рэнд Фишкин: "... вы можете пренебречь рекомендациями Google, использования максимум 100 ссылок на странице, а использовать вплоть до 250-300 ссылок".

Как было сказано выше, Google может увидеть около 250 ссылок даже на сайтах, не имеющих ни одного бэклинка. Но действительно ли есть такое ограничение? Мы провели эксперимент, только поставив на странице не 250 ссылок, а 5 000. Когда Googlebot зашел на сайт произошло что-то интересное. Он запросил следующие страницы:

- example.com/1/

- example.com/10/

- example.com/100/

- example.com/1000/

На каком бы уровне Google не находился, он постоянно запрашивал эти страницы. Это выглядело так, как будто поисковик не знал, как просмотреть такое количество ссылок и пытался решить эту проблему как компьютер.

Семантический интеллект

Еще одним из SEO мифов, который применяется почти на каждом хорошо оптимизированном сайте — это размещение ссылок в тегах заголовков. Если Google "уважает" форматирование, тогда он обязательно должен придать больше веса ссылкам, стоящим в тегах заголовков.

Это не говорит о том, что Google никак не использует семантические алгоритмы, это говорит лишь о том, что он никак не выделяет ссылки в заголовках среди других.

Просмотр JavaScript

По заявлению представителей, Google улучшил алгоритмы чтения и распознавания JavaScript. JavaScript не является лучшим методом, если вы хотите заставить Google следовать ссылкам.

Единственный код, который Googlebot разобрал и последовал ссылке это был простой "document.write". Это никак не означает, что Google может распознавать и читать более продвинутый JavaScript.

Просмотр "Хлебных Крошек" (Breadcrumbs)

Хлебные крошки являются базовым элементом любого сайта сделанного для людей. Иногда их используют так же для улучшения структуры сайта. В прошлом месяце у нас возникали некоторые проблемы с их индексацией ботом, поэтому мы решили провести тесты.

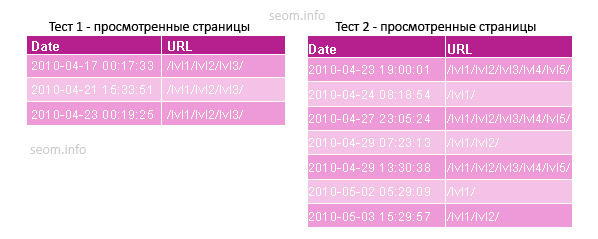

Мы создали страницу в нескольких кликах от главной, наполнили ее контентом и на ней поставили ссылки на предыдущие страницы (example.com/lvl1/lvl2/lvl3/). На страницу мы поставили несколько бэклинков и начали ждать Googlebot. Самая дальняя от главной страница была посещена 3 раза, а предыдущие ей страницы ни одного.

Для того, чтобы убедиться в результатах теста мы проделали его на другом домене. На этот раз страница находилась еще дальше от главной (example.com/lvl1/lvl2/lvl3/lvl4/lvl5/ ). На этот раз Googlebot перешел по нескольким ссылкам, ведущим на более близкие страницы к главной. Не смотря на то, что Googlebot и прошел по некоторым из ссылок, хлебные крошки не являются хорошим методом улучшения структуры сайта.

Даже спустя несколько недель, Google так и не просмотрел все оставшиеся страницы. Googlebot скорее проходит по ссылкам в хлебных крошках от главной в "глубину", чем наоборот.

Выводы о роботе Google

Вкратце, тесты показали, что на ускорение просмотра поисковиком страниц действительно влияет карта сайта. Это не означает, что вы обязательно должны загружать ее. Вы ускорите просмотр страниц поисковиком если некоторая часть страниц уже проиндексирована.

Поисковик чаще всего возвращается на уже проиндексированные страницы. Если же ваши страницы были просмотрены поисковиком, но выпали из индекса, это означает, что вам нужно получить больше бэклинков на каждую из них, прежде чем прибегать к карте сайта.

Необходимо постоянно следить за тем, когда поисковик в последний раз заходил на страницу. Придерживаясь данного метода, вы всегда сможете определить проблему.

Источник: New Insights into Googlebot

Перевод: SEOM.info

#1 by 3TAJIOH on 10/08/2010 - 12:04

Отличный эксперимент.

Карта сайта должна быть в xml или просто страничка со ссылками?

#2 by Антон on 10/08/2010 - 13:19

Да обе наверное можно использовать.

#3 by rin on 10/08/2010 - 17:02

Эту карту можно ведь сделать самому просто сделав страничку написать туда названия страниц и поставить нужные ссылки?

#4 by BFox on 10/09/2010 - 10:12

To above: лучше конечно использовать xml по стандартам гугла, тогда это будет sitemap а не страничка с ссылками.

Seom.info

Замечательные эксперименты, многие уже были в догадках и проскакивали сайты с 1000-ми ссылок, которые все-таки индексировались, может с меньшим весом..

Очень интересный эксперимент с бредкрамбсами, а то всегда чуть ли не первый SEO- совет это установка их..Хотя увеличивают рассредотачивания "веса" (если он есть )

)

#5 by Михаил on 10/09/2010 - 10:16

XML-карта - более эффективный способ предложить роботу страницы для индексирования. Если ваша cms не поддерживает автоматическое создание и поддержку xml-карты сайта, воспользуйтесь сторонними сервисами.

Учтите, что в этом случае придется создавать заново карту сайта при появлении или удалении документов на сайте. Проще, конечно, настроить cms для автоматической работы.

#6 by lionarts.ru on 10/09/2010 - 12:14

Для движков давно уже АВТО компоненты по карте сайта есть. Ещё вопрос такой, когда будет апдейт гугл page rank?

#7 by 3TAJIOH on 10/09/2010 - 18:25

#5 Сервисы УГ, почти все с ограничением.

Рекомендую десктопную программу Sitemap Generator. Обзор тут: 3tajioh.ru/page/sitemap-generator

#8 by Назар on 10/09/2010 - 23:33

Тупой вопрос про пейджранк. Это то самое, что гадать на кофейной гуще

#9 by fkrjy on 10/10/2010 - 11:34

Получаеться что карту сайта тоже надо разбивать?

#10 by BigOriginal on 10/10/2010 - 20:14

Все, пошел делать карту сайта

#11 by CaHbKa on 10/10/2010 - 22:23

На счет гуглы хочу спросить, вот есть сайт который уже проиндексирован гуглом и яндексом, контент на сайте полностью самописный.

Но вот кол. страниц в яндексе в три раза больше чем в гугле.

И такую тенденцию наблюдаю на многих сайтах.

Аналогично и на вашем:

Яша: 799 страниц

Google: 160

Хотя аналогично контент у Вас так же полностью самописный.

В чем тут подвох?

#12 by kladez-zolota on 10/10/2010 - 22:29

наверное, что-то пропустила, но ни чего не поняла.

#13 by BestMasterиZация on 10/11/2010 - 12:01

fkrjy, я рекомендую разбивать лишь html карту. Если же карта сайта в XML формате, то она может быть и одна. Гугл и Яндекс едят ее с удовольствием.

#14 by MyOST on 10/11/2010 - 14:18

Для поисковиков нужна XML карта, для пользователей - обычная HTML.

Лучше - комбинировать, в том числе и перелинковкой. Всегда лучше сумма определенных работ, которая приведет к хорошему результату.

Нужно создавать правильные страницы карты-сайта, если страниц очень много. И их прокачивать тоже.

#15 by cahek on 10/11/2010 - 20:46

Еще бы обзор про яндекс...

#16 by Крылатый on 10/11/2010 - 23:07

Далеко не все осмыслил, но точно разобрался с установкой карты сайта), которая помогает ускорить поисковый процесс.

#17 by Diamaxx on 10/12/2010 - 15:05

cahek - яндекс скоро хочет выйти на мировой уровень яндекс.ком

потому все может изменится.

и да - спасибо за статью - предложил её знакомым сео-копирайтерам.

#18 by Денис on 10/14/2010 - 19:10

скорость просмотра поражает...

#19 by Ваня on 10/18/2010 - 10:38

не думал что карта сайта такое влияние на индексацию оказывает..

#20 by Charger on 10/18/2010 - 19:29

Еще одину вещь мне удалось заметить:

Если на сайте установлен рекламный блок AdSense то скорость индексации падает причём очень сильно.

После снятия AdSense нужно прождать около четырёх дней пока скорость индексации опять поднимется.

#21 by Михаил on 10/22/2010 - 15:55

Интересная статья конечно... Но я постоянно пользуюсь картой сайта и почему-то это не всегда работает (((

#22 by Laith on 10/23/2010 - 18:01

Ситуация с яндексом аналогичная? Пробовал добавлять сайтмап для одного проекта. В итоге гугл вообще забыл про сайт на неделю, зато потом за один день добавил около 1600 страниц.

#23 by Den on 10/25/2010 - 19:09

На опыте понял, что карта сайта это сила))

Laith, тоже бывало, что поисковик ноль внимания, а потом как хапанёт страничек, но в последствии много скинет и потом уже потихоньку набирает.

#24 by Alex Berg on 10/28/2010 - 09:40

Я не так давно занялся seo и ваша статья немного добавила ясности. Спасибо.

#25 by Pavel on 10/30/2010 - 09:49

Роботы поисковых систем прочёсывая интернет переходят по ссылкам. А страница, на которую нет ссылок не проиндексируется. А так нужно помогать роботу проиндексировать и правильно ранжировать странички сайта

#26 by Александр on 11/01/2010 - 20:06

Блин, обожаю такие эксперименты с Гуглом!)))

Буквально пару дней назад сделал пост на тему индексации страниц гуглом. Но эксперимент конечно рулит!

Кстати в посте я указывал еще такой способ заставить гуглбота индексировать страницы сайта - размещение гугловского кода на своих страницах (т.е. работать с сервисами типа Google Adsense, Google Analytics, Google maps и др). Интересно было бы провести такой эксперимент...

#27 by Search Bot on 11/05/2010 - 22:33

...Скорость индексации Яндексом или Гуглом?

#28 by cs on 11/06/2010 - 11:03

Гугл рулит, последнее время индексирует просто со свистом. Эффект, даваемый новыми бэками можно увидеть уже через 10 часов.

#29 by winchester7 on 11/07/2010 - 20:46

Интересно, а если создать карту сайта, дать ее скушать гуглу, потом добавить материала и не обновлять карту, то сайт будет индексироваться хуже, чем если бы обновили или нет?

P.S. Поддерживаю Александра. Не могли бы Вы такой эксперимент провести? И с яндексом тоже можно было бы попробовать. А лучше оба сразу. Типо как яндекс смотрит на размещение google adsense и как смотрит гугл на размещение яндекс.директа =)

И с яндексом тоже можно было бы попробовать. А лучше оба сразу. Типо как яндекс смотрит на размещение google adsense и как смотрит гугл на размещение яндекс.директа =)

#30 by Neko on 11/07/2010 - 22:16

очень интересная статья... Взял для себя много нового) Правда карту сайта я сделал сразу же на xml но теперь хотя бы знаю для чего она ))) Спасибо еще раз)

#31 by Влад on 11/10/2010 - 00:18

Вопрос про карту? Вы просто размещали ее на сайте или добавляли в вебмастер?

#32 by Alex on 11/15/2010 - 08:41

добавляешь карту на сайт и прописываешь в робот.тхт

#33 by Иван on 11/27/2010 - 20:52

Можно вопрос к Алексу. Что конкретно в робот.тхт прописывать?

#34 by Alexandr on 12/02/2010 - 17:02

всегда мечтал узнать как иедксирует гугл. Спасибо автору за статью! Очень интересно

#35 by Роман on 12/05/2010 - 22:50

Статья реально полезная, теперь многое становится понятно, а то всё никак не могу загнать все страницы в индекс Гугла

#36 by Sniper762 on 12/13/2010 - 09:13

конечно все это очень интересно... Но я до сих пор не могу найти плагин для ворд пресса, что бы создать карту сайта(((

#37 by Benz on 12/24/2010 - 14:46

Гугл сильнее Яшки, по любому.