В эру поисковых машин, SEO может быть сведено к 3 основным элементам или функциям: время на обследование сайта (обнаружение), время на индексацию (куда также входит и фильтрация), и время на ранжирование (алгоритмы).

Сегодня первая часть из трех, мы поговорим про обнаружение сайта поисковыми машинами.

Сведение SEO к этим основным элементам позволяет SEOшникам создать своего рода шаблон для работы над продвижением в поисковиках. Применяя этот шаблон можно не углубляться в специфику и тонкости действий в данном шаблоне.

И иногда это нам на руку, так как поисковые машины - это сверхсекретные монстры... роботы-монстры.

Обнаружение — Индексация — Ранжирование

Этот тезис основан на следующих предположениях:

- Googlebot (или бот любого другого поисковика) заходит на страницы для чтения информации. Это всегда будет так, по крайней мере до тех пор, пока Google не научится осмосу.

- Google, основываясь на информации, полученной во время процесса обнаружения, выделяет и анализирует URL в режиме реального времени для того, чтобы принять решения об индексации.

- Основываясь на две вышеперечисленные ступени действий, происходит процесс ранжирования, обычно он очень точен.

- Процесс повторяется.

Поисковики исследуют, индексируют и ранжируют веб-страницы. Поэтому SEOшники должны основывать все свои тактики на этих шагах поисковиков. Вот те простые выводы, которые будут полезны SEOшникам, вне зависимости от конкуренции в нише:

- Все дело в обнаружении страницы

- Все дело в индексации

- Все дело в ранжировании

Но конечно, Google как и все другие поисковики существуют с одной целью — развить бизнес, удовлетворяя потребности пользователей. Поэтому, мы должны постоянно помнить следующее:

- Все крутиться вокруг пользователей

И конечно же, так как по своей природе SEO — это соревнование, в котором для выхода в топ выдачи нужно победить своих конкурентов, мы должны заметить следующее:

- Все дело в конкуренции

Учитывая все вышесказанное, мы можем вывести несколько SEO тактик для каждой из фаз работы поисковика.

Процесс обнаружения страниц

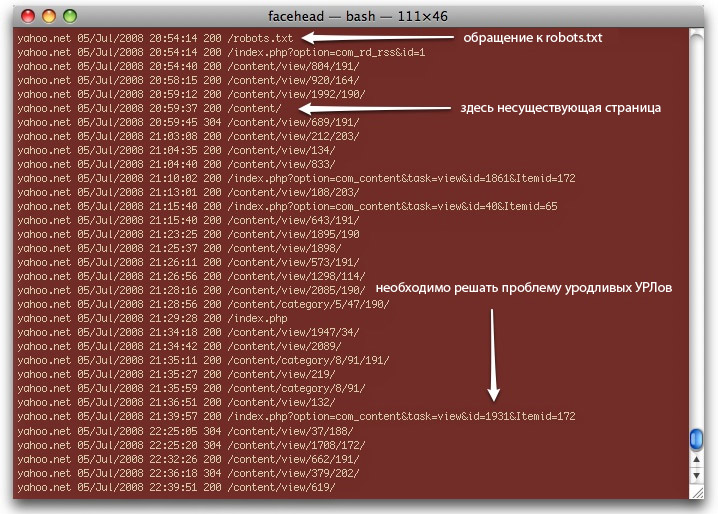

SEO начинается с исследования того, как поисковый бот обнаруживает страницы. Googlebot, например, исследуя наш сайт, видит все детали, которые записываются в логи. Эти несут следующую информацию:

- Сложности обнаружения

- Страницы, которые не следовало читать

- Дубликаты контента

- Частота и глубина чтения страниц

- Наличие ошибок с серверной стороны: 302, 304, 307, 5хх и т. д.

- Наличие цепей редиректов

- Наличие ненужных ошибок 404

Специальные скрипты (AudetteMedia's logfilt), которые помогают быстро разобрать множество таких логов, используются в разных ситуациях:

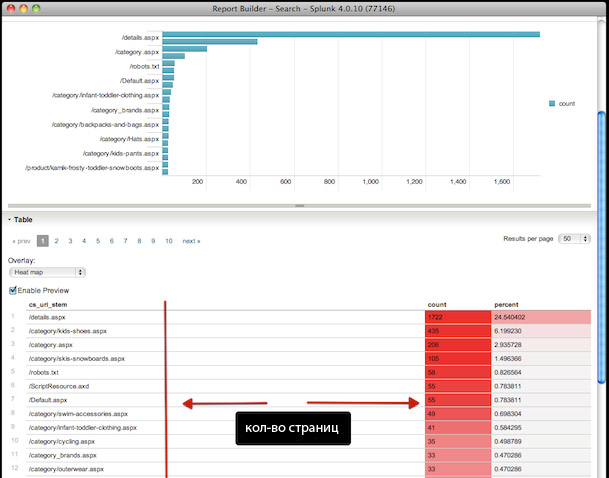

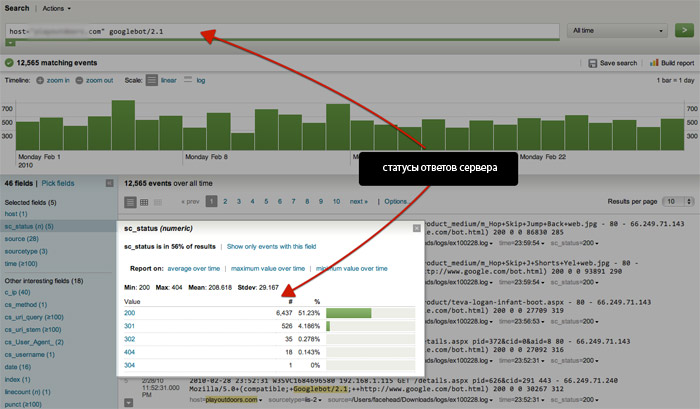

На уровне корпорации существует такой инструмент для анализа как http://www.splunk.com/, который может разобрать всю информацию по user-agent, сортируя ее по коду-статусу сервера, времени и дате:

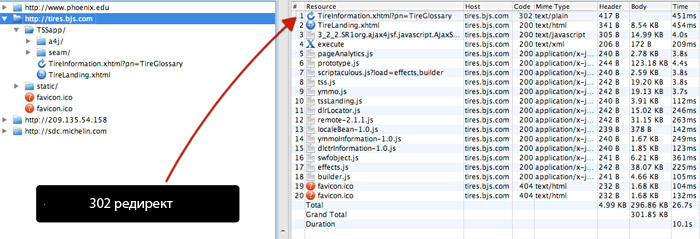

Xenu – это полноценное приложение, которое предоставляет полнейшую информацию о посещении сайта поисковым ботом. Приложение работает с более чем 10 000 страницами, поэтому его лучше использовать на корпоративном уровне. Вот несколько советов по работе с Xenu или подобными:

- Загрузить домен или часть сайта на SEMrush

- Экспортировать все данные по запросам в CSV

- Загрузить этот файл в Xenu или другое приложение

- Отсортировать по коду

Эта быстрая и простая методика помогает найти такие коды как 302 и другие.

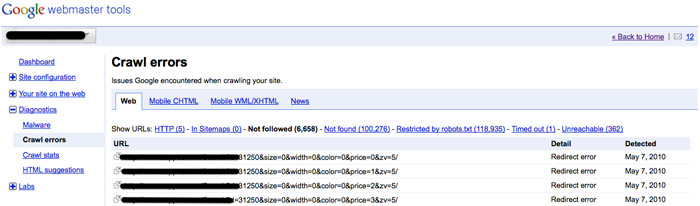

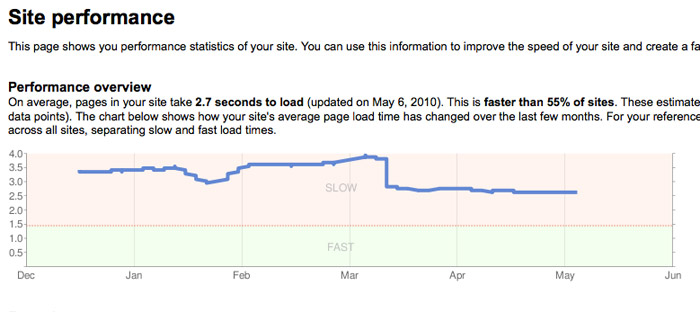

В Google Webmaster Tools также есть полезная для SEOшников информация по обнаружению страницы, дубликатам контента и частоте захождения бота на сайт:

Существуют также и другие инструменты, с помощью которых вы можете посмотреть на страницы сайта глазами поискового бота (например Lynx и SEO Browser ).

SEO – это действия

Самое главное в SEO - это точная информация, но еще важнее то, что и как можно поделать с этой информацией. Все дело в том, как вы интерпретируете данную информацию, а не то, как вы ее достанете.

Подвергая SEO работу систематизации, сообразительные SEOшники делают шаблон действий или методов, основываясь на теорию обнаружения, индексации и ранжирования, что впоследствии приводит их сайты прямиком в топы поисковой выдачи.

Источник: Crawl, Index, Rank, Repeat: A Tactical SEO Framework

Перевод: SEOM.info

#1 by m1pluss on 09/09/2010 - 03:07

Quote

polezno, spasibo.

#2 by Андрей on 09/09/2010 - 06:26

Quote

Спасибо, интересный материал, нужно взять на заметку

#3 by Александр on 09/09/2010 - 13:47

Quote

Очень хорошая статья, спасибо за информацию.

#4 by ganushak on 09/10/2010 - 17:39

Quote

По Xenu немного странно переведен абзац: "предоставляет полнейшую информацию о посещении сайта поисковым ..."

Xenu эмулирует бота поисковика, скачивает все страницы внутри домена, куда может добраться по ссылками с первой заданной страницы и дает подробный отчет о "битых" ссылках, перенаправлениях и т.д.

#5 by GromUA on 09/10/2010 - 22:36

Quote

Статья хорошая, но для меня информация не новая, думал уже что зря читал, но все таки нашол для себя интересную программку Xenu, сейчас пойду тестировать

#6 by ZooZool on 09/12/2010 - 21:55

Quote

Не сказал бы, что материал новый для меня...Но огромный плюс за систематизацию. Все довольно неплохо подано) Читабельность высокая, несмотря на большой объем инф. ( а это часто отталкивает)

#7 by Working on 09/12/2010 - 23:47

Quote

Очень интересная, а, главное, полезная статья! Спасибо!

#8 by kladez-zolota on 09/13/2010 - 07:44

Quote

Мне еще столько нужно разбираться, не знаю с какого края подойти.

#9 by MagistrZoom on 09/13/2010 - 08:28

Quote

Статью стоит читать, однако для себя ничего не взял..как продвигал сайт так и буду продвигать, меня никто не переубедит

#10 by goodcontexter on 09/13/2010 - 08:46

Quote

При всей своей пользе статья античитабельная. Такое ощущение, что запихнули в Google Translate, а потом пробежались по диагонали.

#11 by MyOST on 09/13/2010 - 11:27

Quote

goodcontexter, хотелось бы примера такого перевода, где он "не точен".

#12 by numinoross on 09/13/2010 - 11:52

Quote

Интересно... Все это нужно пока попробовать на своем блоге. Тогда и вывод делать, полезно или нет. За прогу спасибо.

#13 by biwebco on 09/13/2010 - 12:46

Quote

на сайте производителя splunk стоит, что можно скачать программу бесплатно. Скажите, кто пользуется ей, она всегда бесплатная или там какой-то тестовый период только бесплатно?

#14 by Алексей on 09/13/2010 - 13:51

Quote

Также важно знать, какую информацию необходимо достать

#15 by Андрюха on 09/24/2010 - 17:37

Quote

Александр, а чем уродливые урлы могут помешать? почему эту проблему нужно решать?

#16 by FEEL on 10/04/2010 - 19:49

Quote

Спасибо подрочил. А так, полезная статья, особенно полезны ссылки на ресурсы отслеживания сайта глазами поискового бота.

Не знал, что Гугл учится осмосу

#17 by 35metod on 12/29/2010 - 12:09

Quote

отслеживания сайта глазами поискового бота - есть теперь и в Гугле в панели вебмастера

#18 by Denlite on 10/12/2011 - 10:54

Quote

Интересно, но в итоге я вижу, как поисковик смотрит на сайт, что впринципе должно быть очевидно если понимать - поисковик смотрит, как юзер... но не вижу выводов и конкретного описания действий в том или ином случае. Надеюсь это будет освещено в след статьях) Спасибо

#19 by Артур on 02/09/2013 - 15:47

Quote

Слишком сложно для начинающего вебмастера!!!!!

#20 by Андрей on 04/09/2013 - 14:30

Quote

То что я искал, зачёт