Продолжаем серию интересных публикаций на SEOM.info, в этой статье речь пойдет о факторах, которые стоит учитывать при разработке стратегии продвижения сайта, а именно - о факторах, которые так или иначе учитывают поисковые системы.

На часах 9:30 утра, начало рабочего дня, и вы уже беседуете с новым клиентом. Все они очень похожи, такие любознательные, все им интересно и все хотят знать - как поисковик ранжирует страницы, почему предложенные вами изменения дадут положительный эффект, где вы учились SEO, ну и естественно, просят показать примеры ваших предыдущих работ.

Чем глубже вы объяснения клиенту все подробности работы над новым проектом тем плотнее подходите к вопросу наращивания ссылочной массы. Вы рисуете таблицу факторов влияющих на ранжирование страницы поисковиком, на первом месте по важности оказываются ссылки. Клиент спрашивает почему ссылки имеют такое большое значение. Более того, он задает вопрос который ставит вас в тупик:

Как оценить влияние конкретной ссылки на позиции моего сайта в выдаче Google?

В этой статье я попытаюсь вам помочь ответить на этот вопрос. Ниже перечислены большинство самых важных факторов которые влияют на рассчет веса ссылки поисковиками.

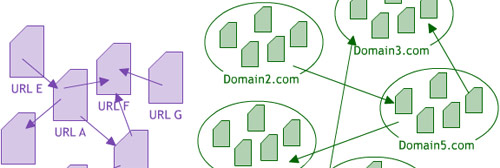

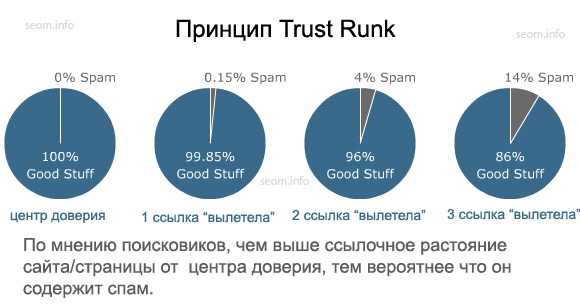

Но сначала, внимательно посмотрите на рисунок, на нем в упрощенном виде изображен очень важный механизм, который нужно знать для понимания ниже изложенного материала:

Как вы уже наверное заметили, поисковые сервера все больше и больше придают значение показателям домена, чем отдельной страницы.

У вас не возникал вопрос, почему все чаще на первых позициях поисковой выдачи мы видим новые страницы с очень небольшим количеством ссылок?

Это объясняться тем, что эти страницы размещены под авторитетными доменами с большим количеством обратных ссылок и высокими внутренними показателями.

Мы провели опрос среди практикующих SEO специалистов о том какие факторы они считают самыми важными при ранжировании, большинство опрошенных поставили "Домен Ранк" (так мы назвали этот показатель) вверху списка, так как считают его одним из ключевых в алгоритме ранжирования Google.

"Домен Ранк" вероятнее всего рассчитывается из его общей ссылочной массы, которая отличается от ссылочной массы отдельных страниц сайта (из которой рассчитывается "Пейдж Ранк" для страниц). Ниже, я расскажу о факторах непосредственно влияющих на один из этих показателей или одновременно на оба.

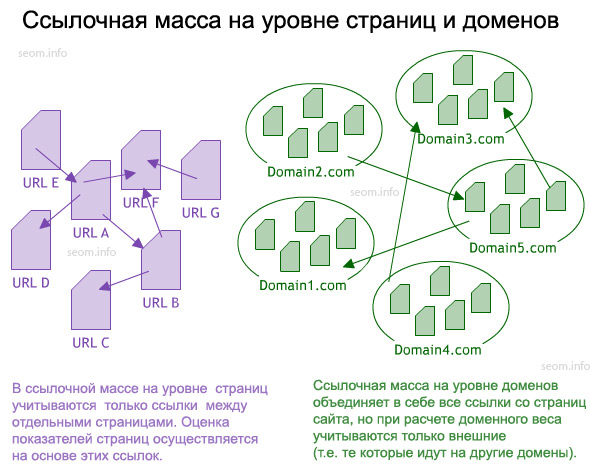

1. Внутренние и внешние ссылки.

Когда поисковые машины только начали использовать ссылки для оценки популярности, важности и релевантности документа заданному поисковому запросу, за основу был взят общеизвестный житейский принцип: что другие говорят о вас, намного важнее (и заслуживает большего доверия) чем то что вы говорите о себе сами.

Таким образом, когда внутренние ссылки (ссылки с одной внутренней страницы сайта на другую) передают какой-то вес, внешние ссылки (с других сайтов) весят значительно больше.

Это еще не значит что не нужно работать над хорошей перелинковке внутренних страниц вашего сайта (стоит делать правильную структуру URL-адресов), или заботиться о качестве внутренних ссылок (хороший текст ссылки, избегать лишних, ненужных ссылок, и т.д.), я просто хотел сказать что SEO показатели страницы очень зависимы от ее цитируемости внешними ресурсами, т.е. количества и качества внешних ссылок.

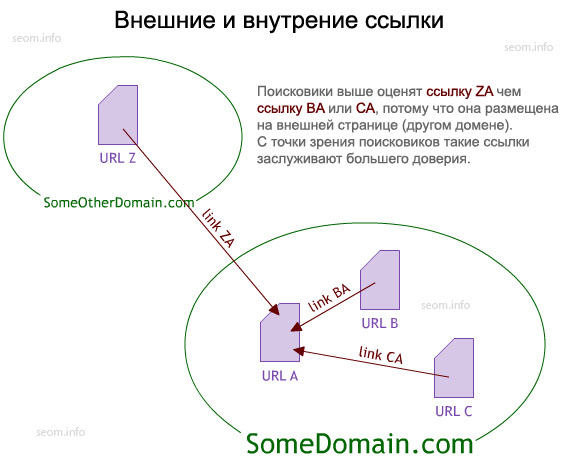

2. Текст ссылки (анкор ссылки).

Для SEO специалистов, хорошо известно, что текст ссылки один из самых важных параметров которые учитывает поисковая машина при ранжировании, поэтому неудивительно что анкорам ссылок уделяют особое внимание.

Из наших SEO экспериментов (а также исходя из огромного практического опыта), стало очевидным что "точное соответствие" текста ссылки предполагаемому поисковому запросу имеет значительное преимущество перед банальным набором ключевых слов в анкоре.

Следует заметить что поисковики не всегда делают такую большую разницу в текстах ссылок, особенно для обычных (не брендовых) ключевых фраз, этим часто манипулируют некоторые продвиженцы для того что бы получить лучшие позиций в серпе.

3. Пейдж Ранк.

Большинство поисковых систем имеют свои собственные пузомерки для измерения веса страниц и , самые распространенные: StaticRank (Microsoft), WebRank (Yahoo!), PageRank (Google), тИЦ (Яндекс) или mozRank (Linkscape's). Большинство из них основанных на цепочном алгоритме Маркова. Если провести аналогию, то ссылки в Пейдж Ранк это как голоса, какая страница набрала больше голосов та и имеет большее влияние в будущем.

Для самого базового понимания основных принципов Пейдж Ранка достаточно знать следующее:

- Каждый URL получает небольшое количество Пейдж Ранка

- Если на странице есть N-е количество ссылок, то каждая из них передает Пейдж Ранк разделенный на N (таким образом чем больше на странице ссылок тем меньше Пейдж Ранка она передает)

- Показатели такие как панель Google в которой есть счетчик PageRank или SEOmoz с mozRank по шкале от 0 до10

PageRank может рассчитываться для ссылочной массы как на уровне страниц, приписывая URL свои показатели, так и на уровне доменов, так называемый Домен Ранк. При расчете показателей на уровне домена, берется во внимание вся ссылочная масса сайта, и на базе ее рассчитывается показатель Домен Ранк.

4. Траст Ранк (уровень "Доверия").

Основные принципы работы этой системы описаны в нашей статье - "О доменных пузомерках. Домен Ранк. Домен Траст. Домен Джус.". Главная идея системы Траст Ранк состоит в том что "хорошие" и с высоким уровнем "доверия" страницы находятся в большей ссылочной "близости" чем страницы содержащие спам, которые на большом ссылочном расстоянии от этого виртуального центра доверия.

Таким образом, пузомерки типа Пейджранк передают только вес, а пузомерки типа Траст Ранк помогают поисковым системам фильтровать спам от качественных ресурсов.

Несмотря на то что поисковые сервисы не предают публичности показатели этой пузомерки, вполне очевидным есть тот факт что "ссылочное расстояние от центра доверия" учитывается при ранжировании страниц. Еще существует Обратный Траст Ранк, который отслеживает кто ссылается на уже известные спам сайты, он также является частью алгоритмов ранжирования.

Также как и Пейдж Ранк, Траст Ранк (и Обратный Траст Ранк) может измеряться на уровне ссылочной массы страниц или для доменной ссылочной массы. В Linkscape мы создали mozTrust (mT) и Домен mozTrust (DmT), но мы все еще считаем что это только начало и предстоит проделать много работы для улучшения измерения этих важных показателей.

Основная идея выше написанного: получайте ссылки с трастовых сайтов, а не потенциальных спам ресурсов.

5. Домен Ранк.

Само определение Домен Ранк (еще известен как "уровень авторитетности домена") часто обсуждается среди SEO экспертов, точного, универсального определения этому понятию все еще нет.

Большинство оптимизаторов под этим общим термином подразумевают комплекс факторов характеризирующих домен: известность, важность, уровень доверия. Домен Ранк для каждого домена рассчитывается поисковыми машинами индивидуально, в первую очередь исходя из ссылочной информации (некоторые специалисты говорят что также при расчете этого параметра учитывается и возраст сайта).

Поисковые сервера учитывают показатель "авторитетности" сайта при расчете веса ссылок, и поэтому всегда нужно учитывать при планировании ссылочного продвижения. Скажу больше, показатели домена могут иметь большее значение чем показатели отдельной страницы с которой идет ссылка на ваш сайт.

6. Разнообразие ссылочных источников.

Мы проанализировали все известные нам ссылочные показатели, и выяснили что с высокими позициями в выдаче самую сильную взаимосвязь имеет показатель характеризирующий разнообразие ссылающихся доменов.

Мы подозреваем это связано с тем, что этим показателем сложнее всего манипулировать, и поисковики используют его как надежный способ для борьбы со спамом.

Как показывает опыт многих SEO специалистов разнообразие ссылочных источников имеет сильный позитивный эффект при ранжировании сайта поисковиками. Следуя этой логике, получается что всегда лучше иметь определенное количество ссылок с разных сайтов, чем то же количество ссылок всего с нескольких сайтов, чем выше разнообразие ссылочных источников тем лучше.

В свою очередь и ссылки с сайтов которые сами имеют большое ссылочное разнообразие (т.е. на них ссылаются много разных сайтов) будут передавать больший вес чем ссылки с сайтов с низким ссылочным разнообразием.

7. Независимость, разные владельцы.

Поисковики могут с помощью разных методов определять принадлежность сайтов одному и том же человеку (или компании), какая существует взаимосвязь между разными сайтами. Среди этих методов следующие (естественно это не все):

- Перелинковка сайтов

- Данные владельца при регистрации доменов.

- Общий IP адрес шаред хостинга или IP адрес C-класса.

- Одна и та же контактная информация на сайтах.

- Документы общего содержания (контракты, договора) выложенные в контенте сайта.

Если поисковики обнаруживают такую взаимосвязь между сетью сайтов, они понижают вес передаваемый ссылками между ними, или вообще отымают возможность передачи ссылочного веса.

8. Положение на странице.

Microsoft был первым поисковиком который публично признался что собирается анализировать блоковую структуру страниц. (в MS Research часть в VIPS - VIsion-based Page Segmentation).

С тех пор SEO специалисты начали замечать в Google и Yahoo такой же элемент аналитики. По наблюдениям нашей компании SEOmoz, к примеру, внутренние ссылки в подвале страницы не передают меньший вес чем ссылки в шапке или боковых панелях.

Некоторые специалисты высказывают мнение что таким образом поисковики пытаются бороться с продажными внешними ссылками, т.е. что бы были непривлекательными те места куда их обычно пытаются запихнуть вебмастера: боковые панели и подвал.

Все сеошники едины в одном - самые ценные это ссылки из "контентной" части страницы, с таких ссылок передается и вес и трафик по ним также идет.

9. Тематическая близость.

Существует большое количество способов которыми поисковики могут определять тематическую близость двух отдельных страниц (или сайтов).

Раньше для этой цели Google Labs использовало алгоритмы которые автоматически классифицировали сайты по тематикам (медицинские, продажа недвижимости, спорт и много-много других) в зависимости от их URL имени, названия категорий и подкатегорий сайта.

Возможно и теперь они используют похожие механизмы для определения "родственных" сайтов внутри разных тематик. Исходя из тематической близости ссылки между сайтами могут передавать больший или меньший вес.

Лично я не всегда забочусь о тематической близости сайтов - если есть возможность получить ссылки с таких авторитетных обще-тематических ресурсов, как например NYTimes.com, почему бы нет, или если какой-то узкоспециализированный блог по каким-то своим причинам решил сослаться на вас, зачем пренебрегать этим.

С другой стороны поисковики используют фактор "тематической близости" для борьбы со спамом. Когда сайт с хорошей репутацией вдруг начинает ссылаться на какие-то тематически отдаленные подозрительные ресурсы (фарма, онлайн-казино, адалт) поисковые системы могут расценить такие действия как спам.

10. Оценка контента.

Тематическая близость может подсказать поисковикам взаимосвязь между ссылками на странице, контент и контекст ссылки играет значительную роль при передаче ссылочного веса с одной страницы на другую.

При конентно/контекстном анализе ссылок поисковики пытаются определить, насколько это возможно сделать машинным путем, почему на этой странице присутствуют ссылки.

Если это естественные ссылки, тогда возможно несколько вариантов. Они могут быть интегрированы в контент, ссылаться на близкие по тематике страницы, использовать стандартные нормы HTML структуры, использование слов, фраз, язык, и т.д.

Анализируя все эти показатели робот может с достаточной точностью отличить естественные ссылки от таких которые присутствуют по другим причинам: тайно проставленные (хакинг), ссылки авторских прав (они передают какой-то вес, но немного), и конечно же платные ссылки.

11. Географическое положение.

Географические данные ссылки взаимосвязаны с сайтом на котором она размещается, но поисковики, особенно Google, все больше и больше уделяют внимание географическому соответствию ссылок к тому сайту на который они ссылаются (так называемая географическая релевантность). Для географической локации сайтов поисковики используют разные определяющие факторы, среди которых:

- IP адрес хостинга.

- По национальным доменным зонам (.de, .co.uk, ru и т.д.).

- На каком языке контент сайта.

- Регистрация сайта в региональных каталогах/поисковых системах/досках.

- Соответствие физическому (реальному) адресу указанному на сайте или в whois данных.

- Географическое положение сайтов которые ссылаются на ваш сайт.

С одной стороны обретая ссылки с сайтов какого-то определенного региона вы получаете возможность оказаться на хороших позициях в локальном поиске для этого региона.

С другой стороны, если все кто на вас ссылается локализированы только в одном конкретном регионе, вам будет сложно продвинуться в поиске для других регионов, даже если ваш сайт для этого имеет все нужные географически-определяющие факторы (IP адрес хостинга, национальное доменное имя, язык контента и т.д.).

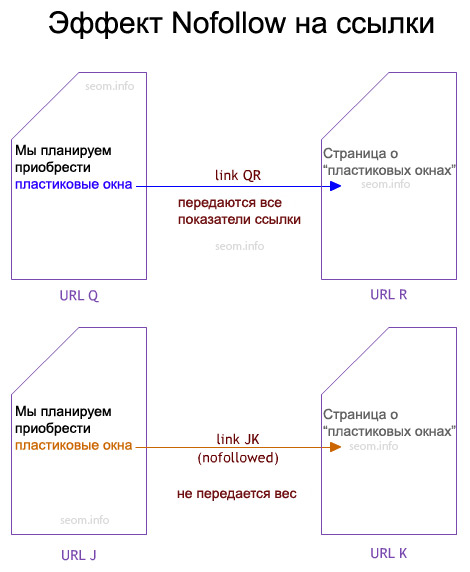

12. Использование Rel="Nofollow".

Иногда кажется что прошло уже очень много времени с тех пор как появился тег nofollow, но на самом деле только в Январе 2005 г. Google объявил об использовании нового HTML тега.

Все очень просто, когда вы ссылку закрываете в тег rel="nofollow", она уже не может передавать никакого веса другим страницам. На сегодняшний день, по данным Linkscape индекса приблизительно 3% всех ссылок в сети скрыто в теге nofollow, причем больше половины из них скрывают внутренние ссылки.

Время от времени среди сеошников постает один и тот же вопрос, всегда и все ли поисковики придерживаются правила этого правила. Общеизвестно что Google может передавать некоторые ссылочные показатели через внешние ссылки Википедии, несмотря на то что они запрятаны в теге nofollow.

13. Тип ссылок.

Ссылки могут быть различных форматов. Три самых распространенных:

- Прямая текстовая HTML ссылка.

- Графическая ссылка.

- Java скрипт ссылка.

Google недавно объявил что они не только научились переходить по ссылкам в Java коде, но также передают через них ссылочный вес (эта новость огорчила многих вебмастеров, который прятали на своих сайтах в Java код платные/рекламные ссылки).

Уже на протяжении многих лет, поисковые системы используют атрибут "alt" в графических ссылках аналогично анкорному тексту в обычных текстовых ссылках.

Как бы то ни было, не все ссылки имеют одинаковый вес для поисковых систем. Мы провели ряд экспериментов, результатом которых стали следующие данные: больше всего веса передают обычные прямые HTML ссылки с стандартным анкорным текстом, за ними идут графически ссылки с насыщенными ключевыми словами "alt" атрибутами и наконец, Java скрипт ссылки (несмотря на то что Google объявил о том что он справляется с таким типом ссылок, их механизм работы с ними еще не совершенен, по крайней мере об этом свидетельствует наш опыт).

Хотелось бы обратить внимание всех тех кто собирается наращивать ссылочную массу для своего сайта, что поисковики все еще плохо работают с "нестандартными" ссылками, поэтому в первую очередь нужно пытаться получить прямые текстовые HTML ссылки с правильным анкорным текстом, они будут самыми эффективными.

14. Разнообразие ссылающихся страниц.

Когда страница имеет внешние ссылки, при расчете веса передаваемого по ссылкам учитывается не только количество ссылок, а также количество сайтов на которые ссылаются.

Как мы уже отмечали выше (пункт 3), алгоритм "Пейдж Ранка"- вне зависимости в какой он поисковой системе, делит весь ссылочный вес страницы на количество исходящих ссылок на ней.

Кроме этого, поисковики оценивают на какое количество доменов идут все ссылки. Если, например, ссылки из контента страницы идут всего на несколько доменов с качественным релевантным контентом, тогда они могут передавать больший вес чем то же количество ссылок с разных углов страницы на разные домены некачественных сайтов по отдаленной тематике.

Также поисковик отслеживают на кого еще кроме вас ссылается та или иная страница. Получать ссылки со страниц которые кроме вас ссылаются на какие-то сайты с сомнительной репутацией это всегда намного хуже чем со страницы которая ссылается на другой качественный и авторитетный ресурс.

15. Санкции поисковых систем.

Каждый кто профессионально занимается SEO бизнесом, видит в своем страшном сне санкции которые могут накладывать поисковики, результат которых может быть от потери возможности передавать ссылочный вес до полного бана страницы или сайта в поисковике.

Если сайт или страница теряет возможность передавать ссылочный вес, тогда продажа ссылок с нее теряет всякий смысл.

Имейте ввиду что поисковики могут использовать самые разные приемы санкций (невозможность продвигаться по определенным запросам, понижение показателей Пейдж Ранка, и т.д.) в первую очередь это направлено против тех кто систематически пытается манипулировать результатами выдачи, но алгоритмы все еще не совершенны и под фильтры могут попасть также случайные страницы.

16. Контент/Интегрированные данные.

На сегодняшний день в сети очень популярен интегрированный контент с различных хостинг сервисов (видео, документы, фотографии, файл - хостинги и т.д.) который содержит в себе обратные ссылки на домашний сайт.

Я не думаю что поисковые системы полностью откажутся учитывать эти ссылки, но все же будут пытаться ограничивать вес и значимость таких ссылок, даже несмотря на то что эти сайты не являются спам ресурсами и очень полезны для пользователей сети.

В нашей компании SEOmoz, мы склонны к мнению что поисковые машины сопоставляют контент сайта с ссылками размещенными на нем, для того что бы определить уровень ссылочного разнообразия и качество ссылок.

Когда поисковые машины видят один и тот же контент с одними и теми же ссылками на тысячах разных сайтов, это есть сигналом для них о понижении уровня показателя ссылочного разнообразия. Этот вопрос может быть предметом дискуссий, но поисковые системы пытаются найти и отфильтровать ссылки полученный таким способом, что бы избежать дальнейших манипуляций.

17. Хронология и история ссылок.

Время и дата появления ссылок идут последним пунктом в нашем списке (но это никак не понижает значимости этого фактора).

Роботы поисковых машин путешествуя в сети собирают и сравнивают информацию о том как новые и старые сайты обретают ссылки, эта информация в первую очередь нужна поисковикам для борьбы со спамом, к тому частота с которой сайт получает новые ссылки влияет на уровень его авторитетности, поэтому новые сайты которые очень быстро получают большое количество ссылок могут вызвать подозрение.

Как используют поисковые системы все вышеперечисленные факторы это уже отдельная тема для дискуссий и дебатов, но все они однозначно учитываются в алгоритмах ранжирования, и влияют на позиции в серпе.

Ну и самый последний совет - избегайте одновременной покупки большого количества ссылок, так как поисковик может воспринять это как спамерские действия, а это существенно отразиться на позициях вашего сайта.

Хотя наш список содержит много пунктов, не нужно считать его догмой, используйте то что считаете нужным. Мы будем рады если вы его дополните какими то своими советами, или поделитесь с нами своим опытом.

Автор: Rand Fishkin (Рэнд Фишкин)

Оригинал: 17 Ways Search Engines Judge the Value of a Link

(17 факторов которые учитывают поисковики при расчете веса ссылки)

Перевод: SEOM.info

#1 by RomanOrlov on 04/22/2010 - 08:37

Quote

Статья хорошо переведена. Я тоже пытался ее переводить, но честно скажу - у вас сделано лучше.

#2 by Сергей Новиков on 09/22/2010 - 16:36

Quote

Спасибо. Было интересно прочитать. Правда, про Траст Ранк не до конца понял, как он работает.... Надо что-нить еще по этой теме почитать.

#3 by Серега on 02/19/2011 - 15:14

Quote

нужна эта стятья хотел распечатать. У меня есть возможность вывести страницу на печать?

#4 by Мирослав on 11/28/2011 - 11:37

Quote

Всем привет! Я создал сайт, выждал пол года, пришло время закупаться вечными беками. Теперь нужно понять, какие беки передают больший вес? Я написал в ПС “какие ссылки передают больший вес” и попал на вашу статью, но несмотря на такой большой пост я не нашел то что искал. Что я искал?

Я слышал такую тему, типа ссылки формата site.com передают больше ТИЦ и PR чем к примеру “комнатные цветы”. Скажите пожалуйста это правда или нет? Ведь в это легко поверить, так как все вполне логично. Человеку который хочет на вас сослаться не нужно маскировать сайт, они чаще всего без задней мысли кидают в поле ссылки URL и не парятся.

P.S. Спасибо под..чил. И я верю в демократию!

#5 by MyOST on 11/28/2011 - 11:51

Quote

Мирослав, а в чем измеряется вес? как его сопоставлять?

По тиц и пр не отвечаю - вопрос не интересный, хотя перенаправляется к вопросу предыдущему.

#6 by Мирослав on 11/28/2011 - 15:43

Quote

Ах, убрал мою ссылочку, все труды и старания погубил… А в самом тексте правильно сделал, я не думал что обработчик преобразует текст в гиперссылку.

По тиц и пр не отвечаю – НУ И ЗРЯ! Заелся наверное… А ведь я ждал ответа, создал компанию на ггл, купил около 40-ка ссылок с анкорами “пси тесты”, а теперь хочу с “site.com”. Но блин не могу понять, получу ли я больший вес таким образом. Ну да ладно, хозяин барин.

P.S. Я как-то смотрел ваше видео и был готов к чтению статей с использованием элементов молодежного фольклора. (да и ваша фава к этому подводит) Я конечно был польщен вашей методичностью в видео интервью, но то, как вы ответили мне – обидело меня. У меня сложилось впечатление, что мне ответил мизантроп.

P.S.2. Рекомендую поле your website подписать your SEO website.

#7 by MyOST on 11/28/2011 - 16:00

Quote

Я не вижу связи между освещаемой в статье темой и ТИЦ, также не вижу связи между SEO и ТИЦ, поэтому на вопросы не связанные с темой не отвечаю, считая их не интересными.

Блог не про то как нарастить тиц, а про то как правильно заниматься развитием сайта/бизнеса. Не занимаюсь ТИЦом, мне нечего ответить на поставленный вопрос, никаких исследований на эту тему тоже не провожу, т.к. ссылками не торгую и данные вопросы оставлены далеко позади (на несколько лет позади).

#8 by андрей on 01/13/2013 - 20:52

Quote

скажите пожалуйста,а вот у меня вылетело три страницы,прочитал где-то что яндекс бывает выкидывает и возвращает назад со временем,частично сайт выпадает по каким чаще всего причинам? есть соображения на этот счет?

#9 by Seoberloga on 01/09/2014 - 11:12

Quote

Пока не покупал себе на блог ссылки, благодаря вашей статье теперь буду знать на какие факторы покупных ссылок следует обратить внимание.

Главное правило это наверно предпочесть количеству качество