Сегодня разбирал один из сайтов клиентов, свежих, дак просто руки опускались сколько там проблем. Дубли контента внутри сайта - их было ровно 67% от общего объема сайта. Но разбирать мы будем на основе популярного ресурса ROEM.RU, тем более здесь тоже хватает проблем.

Раньше у нас уже была статья по дублям: "Дубликаты контента – мифы и решение проблемы", но сегодня мы коснемся Рунета и Яндекса в частностях.

Одинаковых сайтов не бывает. Поисковики тоже относятся достаточно по разному к разным сайтам. Что одному - как слону дробина, то другому - последний гвоздь в крышку гроба. ROEM.RU - достаточно авторитетный ресурс, но не исключено что и он может попасть однажды в проблемную ситуацию.

Давайте попытаемся посчитать, сколько на самом деле на сайте контента, чистого, без всякого шлака.

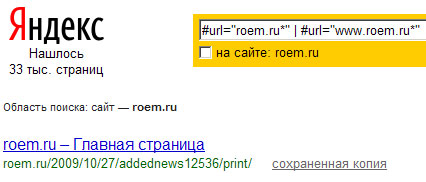

Итак (на 24 марта 2010 года), Яндекс знает 33 тысячи страниц, Гугл знает 37 тысяч страниц, Рамблер знает 41 тысячу страниц. Что же это за страницы?

Давайте по порядку начнем отсекать.

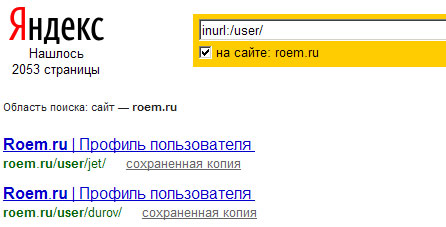

Убираем профили пользователей из проиндексированных страниц - это 2 тысячи.

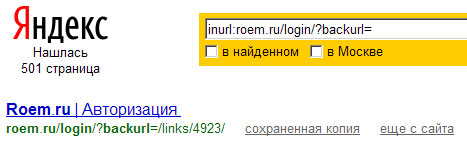

Дальше отсекаем страницу авторизации - это 500 страниц.

Теперь перейдем непосредственно к дублирующему контенту по содержанию страниц.

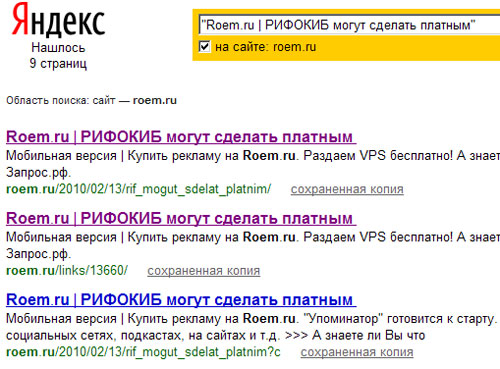

Как мы видим на каждую информационную страницу приходится 5 копий, а именно:

- roem.ru/2010/02/13/rif_mogut_sdelat_platnim/

- roem.ru/2010/02/13/rif_mogut_sdelat_platnim?c

- roem.ru/2010/02/13/rif_mogut_sdelat_platnim

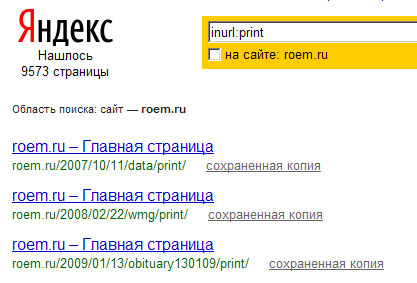

- roem.ru/2010/02/13/rif_mogut_sdelat_platnim/print/

- roem.ru/links/13660/

- roem.ru/links/13660/?c

А хотите еще добавить? Да пожалуйста:

- roem.ru/2010/02/13/rif_mogut_sdelat_platnim?c/print/

- roem.ru/links/13660/?c/print/

Т.Е. если разобраться, у нас 5 четких копий, которые знает Яндекс, а также можно сделать еще минимум +2 копии, а при желании я уверен можно и еще больше. Но давайте будем разбираться только с тем что видит Яндекс, а не то что можно с ресурсом сделать еще ![]()

Как мы видим - "для печати" это довольно большой сегмент на сайте - почти 10 тысяч страниц.

Итак, подведем итог, сколько же реального содержания на сайте и сколько знает Яндекс.

В индексе поисковой системы 33 тысячи документов, из них 2 тысячи - профили, 9500 - страницы для печати, 500 страниц - авторизация. Теперь давайте вычтем ВСЕ дубли контента и системные страницы. В итоге мы получим 5-6 тысяч страниц.

Из 33 тысяч страниц - всего 5-6 тысяч с реальным контентом, 3 тысячи страниц - можно назвать системными в индексе, а 24 тысячи страниц - это дубликаты статей (уточнение - это ТОЛЬКО четкие дубликаты)!

Вот на сайте клиента у меня почти такая же ситуация ![]() придется убирать. На любом сайте есть проблемы - основная задача, от них избавиться, чтобы не иметь проблем в будущем.

придется убирать. На любом сайте есть проблемы - основная задача, от них избавиться, чтобы не иметь проблем в будущем.

Конечно если это не сателлит для продажи ссылок ![]() хотя, как раз на сайте для продажи ссылок в большей степени эта проблема проявляется, они просто тупо вылетают (дубли) и сайт попадает в ГБЛ. Если для сателлита - это просто потеря прибыли, то для нормального сайта, бизнеса, вылет большой части страниц может оказаться губительным (для интернет направления).

хотя, как раз на сайте для продажи ссылок в большей степени эта проблема проявляется, они просто тупо вылетают (дубли) и сайт попадает в ГБЛ. Если для сателлита - это просто потеря прибыли, то для нормального сайта, бизнеса, вылет большой части страниц может оказаться губительным (для интернет направления).

Анализируйте свои сайты, устраняйте проблемы, не зарабатывайте себе геморрой.

#1 by SEOinSoul on 03/24/2010 - 15:01

Quote

А расскажи еще как закрывать будешь эти дубли, чтобы наверняка?

#2 by alvarvas on 03/24/2010 - 15:51

Quote

А что ещё можно сделать, кроме того, что закрыть в робот.тхт?

#3 by MyOST on 03/24/2010 - 17:41

Quote

Type your comment here

Отдавать вместо кода 200 - код 404 (как вариант) поисковым роботам на не существующие варианты страниц.

#4 by NozNet on 03/24/2010 - 17:50

Quote

Ну этот Яндекс, индексирует всё, что не нужно. Как он вообще находит те страницы, на которые ни ссылки ни упоминания нет?

#5 by MyOST on 03/24/2010 - 17:51

Quote

На них есть ссылки, на большинство.

Яндекс индексирует все что возможно, задача администратора сайта - правильно направлять робота, ни больше, ни меньше.

#6 by alexmay on 03/24/2010 - 18:14

Quote

Ну ладно, понятно что 2 тыс. профилей и 9,5 тыс. для печати - это плохо, а если поиск по тегам - дублируется же целевой контент... как быть с этим, если из индекса все равно за год ничего не вылетело?

#7 by MyOST on 03/24/2010 - 18:26

Quote

Теги - это аналогичные дубли, как и любые сортировки и прочие "параметры"

http://seom.info/2010/01/20/audit-yandex-webmaster/ по тегам есть график, как их видел яндекс

#8 by Андрей on 03/24/2010 - 18:48

Quote

В начале статьи вы пишите "Дубли контента внутри сайта - их было ровно 67% от общего объема сайта."

А как вы их определили? Не на каждом сайте есть профили, регистрации и прочие мусорные страницы. Иногда просто дублируется контент - то ли движок криво настроен, то ли еще что... Особенно тяжело, когда движок не знакомый или самописный!

Так вот... Как вы определяете дубли? В расширенном поиске вбивать куски текста с каждой страницы - это тоже не выход. Тем более, если на сайте куча страниц. Это получается чуть ли не скаждой страницы нужно проверять вручную через расширенный поиск.

#9 by MyOST on 03/24/2010 - 18:54

Quote

Методика определения проста - достаточно по 1й статье посмотреть данные, чтобы определить слабые места в настройке CMS, посмотреть через поисковую систему. Посмотреть проиндексированные страницы.

Зачем для каждой страницы это делать? - достаточно на одном примере разобрать все.

#10 by Андрей on 03/24/2010 - 20:48

Quote

"Зачем для каждой страницы это делать? - достаточно на одном примере разобрать все."

-а если на одном примере все ОК. а в остальных некоторых случаях возникают дубли. Может же такое быть?!

И еще хотел бы спросить: что насчет частичного дублирования контента внури сайта? Сколько допустимо, или вообще лучше этого не допускать и вообще какой тут подход?

Спасибо.

#11 by alvarvas on 03/25/2010 - 11:00

Quote

это в штаксесс делается?

#12 by Сергей on 03/26/2010 - 13:09

Quote

Подскажите, каким запросом просмотреть дубликаты в Гугле?

#13 by oldvovk on 03/31/2010 - 08:20

Quote

SEOin soul да наверное никак. Вот тр**нет Яндексу, проигнорит роботс, как и ноиндекс, так и будут дубли по всему поиску.

#14 by Валерий on 11/02/2010 - 14:12

Quote

проблема, подскажите!?

если я пропишу так Disallow: /*/tag/*, то ссылки типа мой сайт.ru/tag/бла бла исчезнут из индекса?

#15 by grindex on 11/17/2010 - 04:44

Quote

долго боролся с дублями, но на сколько я понимаю, если сайт на движке, то с дублями ничего не поделаешь, так что лучшее избавление от дублей - это сделать сайт на хтмл

#16 by gothic on 01/24/2011 - 12:41

Quote

А вот например у меня интернет-магазин одежды , какие страницы нужно запихать в robots.txt?

#17 by Dneprolab on 04/07/2011 - 08:26

Quote

Будет достаточно Disallow: /tag/

Все зависит от конкетного примера, админку точно нужно закрыть.

#18 by aleksandr on 04/28/2011 - 23:07

Quote

Один только robots.txt не спасает от дублей