Не так давно, на конференции "SMX East", в докладе с которым выступал Joachim Kupke (руководитель группы инженеров в отделе индексации Google) заявил буквально следующее "большинство информации в сети это двойной контент, или клонированная информация, или рерайт, как кому больше нравится".

MyOST: никогда не обрывал так, после анонса, своими словами, но хочу сразу настроить читателей на внимательный анализ информации. Материалы, которые публикуются в блоге, должны помочь в очень важном этапе работы над сайтом - формировании ссылочной массы, причем этот материал и ряд ранее опубликованных (дубликаты контента внутри сайта: разбираем на конкретном примере, дубликаты контента – мифы и решение проблемы) должен поставить перед Вами вектор развития, анализируйте. Также не зря был ранее написан материал "фильтрация ссылок и ошибки сателлитщиков" - где тоже были затронуты некоторые аспекты работы с ссылочной массой. На мой взгляд, в этой серии статей содержится ряд фундаментальных принципов, которые позволят более эффективно работать с ссылками. Конечно, я попытаюсь выделить основные моменты.

Мне хорошо запомнились эти его слова, потом после окончания конференции я обсуждал этот вопрос с другими специалистами, все были согласны с таким мнением. Теперь, уже по прошествии кое-какого времени, я хочу несколько усовершенствовать это мнение, и сказать об этом немного по другому "большинство страниц в интернете, не живут долго".

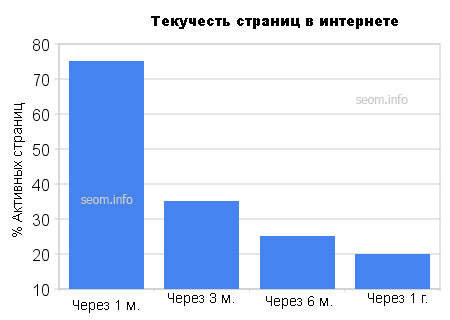

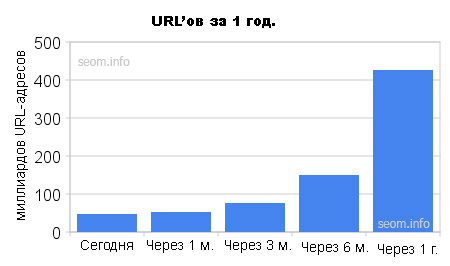

Только по прошествии всего одного месяца, более 25% URL-адресов становиться тем что мы называем "вне доступа". Под этим я подразумеваю, что контент был дублированным, неверные параметры сессии, или другие причины по которым страница недоступна (например 404 и 505 ошибки и т.д.).

Еще через шесть месяцев отпадает еще 75% из оставшихся десяти миллиардов URL-ов, и только через год доступными остается только 20% страниц. Как уже отметил в своей предыдущей статье Рэнд Фишкин, Google проделывает огромную работу по отсеиванию некачественных страниц.

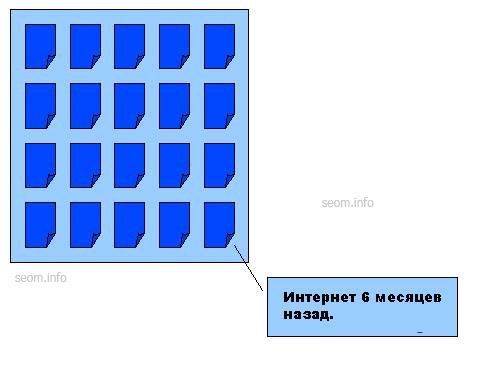

Что бы наглядно представить себе эту драматическую текучесть страниц, представьте вначале себе каким был интернет 6 месяцев назад ... (очень упрощенно это показано на рисунке)

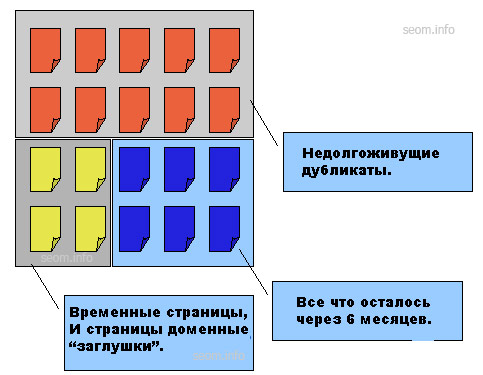

Опираясь на точку зрения Joachim'а, и мои дальнейшие выводы касаемо этого вопроса, у нас получается примерно следующее, полугодичный контент будет выглядеть примерно вот так:

Что это означает для нас, как для маркетологов которые понесли затраты на наращивание ссылочной массы, а потом оказывается, что наши ссылки не такие уж долгоживущие как мы ожидали.

Если ваша ссылочная масса исходила из таких вот страниц "недолгожителей", тогда ваши позиции в СЕРПе, могут варьироваться в очень больших пределах. При наращивании ссылочной массы нужно уметь различать сайты, долгожители и недолгожители.

Первые вы можете использовать для наращивания устойчивой ссылочной массы на перспективу, вторые для быстрого подъема вначале продвижения.

Вне всякого сомнения оба типа этих сайтов очень полезны, но если вся ваша ссылочная масса сконцентрирована на сайтах недолгожителях, тогда по истечению какого-то периода вы рискуете серьезно потерять свои позиции в поисковой выдаче, никогда не следует забывать об этом.

Канонизация, контратипирование и выбор страниц которые следует оставить

Что касается индекса Linkscape, то мы наблюдаем следующее:

- Индекс постоянно обновляется, и его можно считать достаточно свежим и полным. Наш инструмент "Blogscape" очень сильно этому способствует, а именно: непрерывно мониторит более 10 миллионов фидов и отсылает свежую информацию на Linkscape, который ставит свежие страницы в очередь на индексацию.

- Мы собираем только долгоживущий контент, при каждом новом апдейте пытаемся анализировать и сайт, и страницы которые с точки зрения SEO, могут оказаться неэффективными, таким образом мы следим за чистотой нашего индекса. Поэтому индекс нашего сервиса нельзя назвать аккумулятивным (таким который только концентрирует) он очень динамичный, при каждом апдейте что-то отбрасывает, что-то добавляется это непрерывное движение.

Что бы вам было более понятно, представьте себе что качество всех страниц в сети измеряется, например в mozRank:

Мне кажется, что этот график говорит сам за себя. Преимущественное большинство страниц имеет очень низкий показатель "важности" исходя из передаваемого ими веса. Поэтому для меня нет ничего удивительного в том, что после непродолжительного пребывания в сети эти seo-пустышки попросту исчезают. Естественно, не следует забывать о том что существует также огромное количество качественных страниц.

Что это говорит о страницах которые мы сохраняем?

Но сперва, давайте договоримся не принимать во внимание страниц которые мы видели год назад (как уже упоминалось выше только менее 1/5 от них "выжило" в сети). За последние 12 месяцев мы насчитали в сети, от 500 миллиардов до 1-го триллиона страниц в зависимости от способа подсчета.

Итак всего за год мы добавили более 500 миллиардов уникальных URL-адресов в Linkscape и другие инструменты которые работают от Linkscape (Competitive Link Finder, Visualization, Backlink Analysis, и т.д.).

И что еще более важно, здесь представлено только менее половины URL адресов от тех что существуют. Нам пришлось отсечь 50 % страниц так как они не передавали никакого веса, и были просто бесполезны (спамерские страницы, двойной контент, неканоничность, и другие причины).

Я думаю, что существует еще несколько триллионов страниц, но ни поисковые системы, а уж тем более Linkscape, не захотят иметь у себя в индексе этот мусор.

Декабрьское обновление индекса Linkscape

По данным последнего индекса (составлен на протяжении последних 30 дней) мы имеем:

- 47,652,586,788 уникальных URL-адрессов (47.6 миллиарда)

- 223,007,523 субдоменов (223 миллионов)

- 58,587,013 корневых доменов (59.5 миллиарда)

- 547,465,598,586 ссылок (547 миллиарда)

Мы проверили все эти ссылки и URL-адреса. И я могу с долей уверенности назвать их "проверенными", вот некоторые из причин почему я так считаю:

- Ранее мы уже проводили глубокое исследование вопроса как поисковые системы ранжируют документы.

- Влияние на веб (как в традиционном маркетинге) и способность прогрессировать со временем.

- Надежность, авторитетность, полезность предоставленной информации.

- Оценка успешности и путей улучшения дальнейшего продвижения.

Надеюсь вы с этим согласны. По крайней мере, большинство моих знакомых специалистов да ![]()

Источник: Looking Back at Linkscape's Trillion + URLs (and Announcing our Latest Index Update)

Перевод: SEOM.info

#1 by Олег on 03/29/2010 - 02:00

отлично.

#2 by horoshka on 03/30/2010 - 01:26

Как я поняла, под прицелом остаются те страницы, которые вошли в дублированный контент. А значит нужно добиваться каноничности каждой ссылки

#3 by Олег on 08/08/2010 - 16:16

пугающе, в результате становится понятно, что лучший вариант - СДЛ с уникальными текстами

#4 by Alexey on 09/20/2010 - 11:37

horoshka, правильно поняла. Да, уник текст всегда был востребован поисковиками