Еще один полезный материал попадает в рубрику "Учебник по SEO". Еженедельные пополнения интересными материалами обеспечены ![]() Сегодня мы поговорим о дублированном контенте, а также о способах избежать проблем с дублями страниц.

Сегодня мы поговорим о дублированном контенте, а также о способах избежать проблем с дублями страниц.

Долгое время существовало сильное убеждение что поисковые машины – в частности Google – применяют санкции к сайтам которые содержат не оригинальный контент, или имеют контент который очень распространенный (популярный) в сети.

И вот сейчас я хочу заявить вам, санкции за дублированный (т.е. не уникальный) контент - это миф.

MyOST: По поводу "мифа", что за дублированный контент санкций нет, как пишет автор - вот тут я в корне не согласен, на сегодняшний день - дублированный контент это бич современного SEO и главная причина многих проблем. Причем применительно это не только к Гуглу, но и к Яндексу в частности.

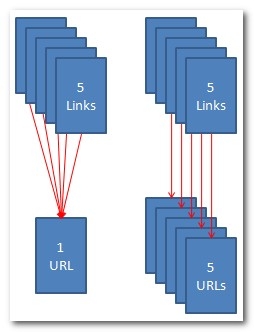

Давайте посмотрим на эту проблему шире. Если какая-то страница с контентом имеет 5 входящих ссылок и эта страница размещена только под одним URL'ом, тогда весь ссылочный вес передается только одному URL.

А теперь представьте что эта страница с контентом и входящими на нее ссылками висит на 5 разных URL'ах, то теперь каждый из этих продублированных URL'ов получит только 1/5 ссылочного веса.

Все эти страницы только вместе имеют такой же ссылочный вес как только одна оригинальная.

Миф о санкциях поисковиков за не оригинальный контент произошел от неправильного понимания самий причины этого явления- распределения ссылочного веса.

Идеальная ситуация для продвижения - это когда один URL для одной страницы с контентом и одним набором ключевых слов. Я бы посоветовал интернет маркетологам сконцентрировать их усилия на оптимизации контента больше чем на попытках избежать его не уникальности.

Причины появления дублированного контента

Много различных обстоятельств могут в результате привести к появлению двойного контента, но всех их объединяет одно: Двойного контента не существует до тех пор пока нет на него ссылки.

Если для сайта возникает проблема не оригинального контента, это означает что где-то появился этот контент но уже под другим URL'oм и на него есть хотя бы одна входящая ссылка.

Ccылки на URLы страниц с продублированным контентом могут появляться, если добавляются трекинг параметры в адрес страницы, если сайт с субдоменом не перелинкован правильно, когда в URL добавляются фильтрационные и сортировочные параметры, когда версия страницы "для печати" создает новый URL, и еще много других вариантов.

Еще хуже, что каждый из них может генерировать другие источники двойного контента, плодить сотни вариаций URL-адресов для одной и той же страницы с оригинальным контентом.

Главная страницы (морда) может быть одним из примеров. Иногда случается и такое - домен по умолчанию есть ссылкой на главную страницу, но кликая по навигационным ссылкам которые должны были бы привести на главную страницу, вы попадаете на нее но уже с другим URL, т.е. в результате получаете страницу с продублированным контентом.

Сайт "Banana Republic" имеет в индексе Google 18 версий домашней страницы, и еще несколько которые не попали в индекс, вот смотрите сами:

http://www.bananarepublic.com/

http://bananarepublic.gap.com/

http://bananarepublic.gap.com/?ssiteID=plft

http://bananarepublic.gap.com/?kwid=1&redirect=true

http://bananarepublic.gap.com/browse/home.do?ssiteID=ON

И каждый из этих URL адресов имеет как минимум одну входящую ссылку.

Подумайте насколько больше было бы веса в морды этого сайта, если бы все входящие ссылки вели на одну настоящую главную страницу, вместо десятка ее клонов.

Типы двойного контента

Плохая канонизация

Недостаток канонизации самая распространенная причина двойного контента. Канонизация означает устранение копий страниц, а в SEO, это еще и концентрация всех входящих ссылок на одном URL адресе, для каждой страницы с контентом. Ниже показаны 10 примеров URL-адресов на одну и ту же страницу:

- Каноничный URL: http://www.example.com/directory4/index.html

- Протокол клон: https://www.example.com/directory4/index.html

- IP клон: http://62.184.141.58/directory4/index.html

- Субдомен клон: http://example.com/directory4/index.html

- Путь к файлу клон: http://www.example.com/site/directory4/index.html

- Файл клон: http://www.example.com/directory4/

- Регистр клон: http://www.example.com/Directory4/Index.html

- Спец символы клон: http://www.example.com/directory%204/index.html

- Трекинг клон: http://www.example.com/directory4/index.html?tracking=true

- Наследственный URL клон: http://www.example.com/site/directory.aspx?directory=4&stuff=more

Хотя в примере и не реальные адреса, но в своей практике я встречал достаточно сайтов которые имели внутри огромное количество вот таких клонированных URL адресов. Даже бывали случаи когда ссылочный вес распределялся между одинаковых 1000 URL'ами. Оригинальная (первоначальная) страница была бы намного сильнее если весь ссылочный вес был направлен только на один URL.

Самый эффективный способ канонизации двойного контента это, сконцентрировать все входящие ссылки на оригинальную страницу через 301 редирект ее клонов.

Каннибализация

Каннибализация - это когда две или больше страниц сайта оптимизированы под один и тот же набор ключевых слов.

Онлайн магазины попадают в эту петлю очень часто когда из соображений улучшения юзабилити сайта: фильтрация товара , сортировка товара , количество единиц показываемых на странице, рекомендовать другу по e-mail и т.д. генерируются страницы дубликаты, полностью или частично похожие на оригинальную страницу.

Технически они не 100 %-е дубликаты. Без этих страниц нельзя обойтись, они нужны для юзабилити сайта, поэтому делаем им 301 редирект на оригинальную страницу.

В этом случае владельцы сайтов имеют только два выбора:

- Делать разнообразный контент с разными наборами ключевых слов.

- Воспользоваться каноническим тегом (<link rel="canonical" href="http://seom.info/seo-book/" />) чтобы собрать ссылочный вес без перенаправления посетителей.

Решение проблемы

Запомните, что 301 редирект это лучший друг СЕОшника когда речь идет о двойном контенте или канонизации.

Если вы не можете использовать редирект потому что эта страница нужна для людей, тогда ваш второй друг это канонический тег, что бы аккумулировать ссылочную массу.

Есть и другие способы для удерживания контента — meta тег noindex, файл robots.txt тег disallow, и 404 ошибки — но они только закроют контент от индексации, но не предохранят его от утечки ссылочного веса.

MyOST: Я думаю тут будет полезно прочесть предыдущую статью в блоге: "Укажите Google какие параметры URL адресов игнорировать".

Источник: There Is No Duplicate Content Penalty.

Перевод: SEOM.info

#1 by hawot on 10/30/2009 - 13:14

Но ведь яндекс не понимает rel="canonical", а google не понимает тег noindex, и редедрект не всегда применим. Однозначного решения для рунета, как мне кажется, нет.

В первом абзаце описка: "с доблями".

#2 by MyOST on 10/30/2009 - 13:42

Спасибо за опечатку поправил.

поправил.

Однозначного решения никогда нет, хотя для гугла http://seom.info/2009/10/27/google-url-ignore/ решение здесь описано, в вариациях.

Редирект, ИМХО, предпочтительней.

#3 by kukushka on 10/30/2009 - 18:32

Спасибо !

#4 by maya on 10/30/2009 - 22:58

Отличная информация!

Теперь хоть буду знать зачем у меня на блоге rel="canonical"

#5 by Дмитрий on 11/02/2009 - 15:15

Это все работает в стерильных условиях Гугла - там можно и канонический урл указать, и ненужные страницы из индекса убрать, и параметры урла (сессии) отрезать, и способ отображения (с\без www) выбрать.

В Я., к сожалению, это не работает.

Хотя у меня создалось впечатление, что Я. не пессимизирует за дубль контента - у меня в топе по СЧ внутренняя страница, имеющая два клона (контент-плагин от известных немецких братьев генерит разные ссылки на страницу в главном меню, категории и RSS). Загружены по Я.вэбмастеру все три, а в индексе только одна – та, которая представлена в главном меню.

#6 by MyOST on 11/02/2009 - 15:31

Единичный случай НЕ пессимизации за дубль контента - не показатель, есть масса других, более печальных примеров, к сожалению.

По поводу того, что к Яндексу не применимо то что здесь опубликовано, не зря выделил я пункт "Решение проблемы".

#7 by Сергей on 08/20/2010 - 00:18

Спасибо огромное автору за статью!

Рад, что наткнулся на Ваш блог именно сейчас, когда у меня остро стоит вопрос с дублями на сайте.

Подскажите, пожалуйста, по нескольким вопросам:

1) У меня на джумле после установки ЧПУ появилось по 4-5 дублей одной страницы. Это решается, как я понял 301 редиректом. У меня сейчас есть один редирект в хтаксесс со страницы сайта на главную:

Options +FollowSymLinks

redirect 301 /glavnaya/ http : //www.mysite.com

Как можно сделать всё пакетно для разных дублей одной страницы что бы не лупить в хтаксесс все редиректы для дублей(очень много получится)?

Как правильно прописать редирект в хтаксесс для дублей многих страниц сайта?

Спасибо!

#8 by MyOST on 08/22/2010 - 11:39

Сергей, если не делать 301 редирект для каждого проблемного урла, то вы потеряете его вес. Другой альтернативы нет.

Если страница была - она может просто исчезнуть, если отдает 404 или передать имеющийся вес через 301 редирект. Иной альтернативы при исчезновении урла я не знаю.

Да, работы много предстоит - но увы.

#9 by Сергей on 08/22/2010 - 23:38

Спасибо за ответ, MyOST!

С 301 определился, буду делать. Вот только вопрос: как правильно его сделать для n-количества страниц на которые идут по 4-5 дублей?

Можно я спрошу, правильно ли делать мне так:

Options +FollowSymLinks

redirect 301 /glavnaya/ http : //www.mysite.com (этот редирект у меня уже стоял)

redirect 301 /index.php?option=com_sobi2&Itemid=1&catid=6&lang=ru&sobi2Id=3&sobi2Task=sobi2Details/ http : //www.mysite.com/page1

redirect 301 /index.php?option=com_sobi2&Itemid=1&catid=7&lang=ru&sobi2Id=3&sobi2Task=sobi2Details / http : //www.mysite.com/page1

redirect 301 /index.php?option=com_sobi2&Itemid=28&catid=7&lang=ru&sobi2Id=3&sobi2Task=sobi2Details/ http : //www.mysite.com/page1

redirect 301 /index.php?option=com_sobi2&Itemid=1&lang=ru&sobi2Id=3&sobi2Task=sobi2Details/ http : //www.mysite.com/page1 ?

Это пример дублей для одной из страниц сайта. А этих страниц с дублями очень много. Поверьте, мне не трудно будет для каждой страницы прописать редирект в хтаксесс. Но я спрашиваю: будет ли правильно это сделать именно таким образом?

Получается, что файл хтаксесс у меня примет невообразимо большой код с редиректами, и при добавлении новой страницы мне придётся добавлять в хтаксесс новый редирект для вновь созданной страницы.

Вот и спрашиваю, будут ли мои действия правильными или как-то можно будет обыграть по-другому?

Очень важный для меня момент, поскольку не хочется сейчас что-то запороть.

Спасибо!

#10 by MyOST on 08/23/2010 - 00:06

Сергей, да так - проверяя как срабатывает прежняя структура - действительно ли работает (здесь есть пробелы - которые стоят чтобы не активировались ссылки в комментариях просто).

Также нужно смотреть чтобы сама ждумла отрабатывала корректно (вроде есть под нее плагин, который это автоматизирует, не знаток этого движка, не посоветую). Поищите, возможно это окажется лучшим вариантом, чем htaccess. Хотя суть там останется аналогичной - 301.

#11 by Сергей on 08/23/2010 - 23:02

Спасибо огромное!

Буду работать, надеюсь, что найду какую-нибудь автоматизацию этого процесса, да и не в объёме самой работы дело, а в том, что бы не засорять сильно хтаксесс.

#12 by porcelanosa on 08/28/2010 - 16:12

1) А как бороться с PHPSESSID? Видела несколько вариантов, какой все-таки лучше?

2) И еще страницы для печати тоже убирать из индекса? Их наверное проще всего в robots запретить?

#13 by Sergey on 06/16/2011 - 23:45

Вопрос таков как поставить в ВП rel="canonical" именно на на нужной старнице? в хедер же не пихнешь этот тег